🚀 Qwen2.5-Omni-3B GGUF模型

Qwen2.5-Omni-3B GGUF模型是一种多功能的模型,具备处理多种模态数据的能力,可用于文本、图像、音频和视频等多种数据的感知与处理,能为用户提供高效且准确的信息处理和响应。

🚀 快速开始

本项目主要围绕Qwen2.5-Omni-3B GGUF模型展开,下面将为你介绍该模型的生成细节、量化方法以及如何选择合适的模型格式。

✨ 主要特性

模型生成细节

此模型使用 llama.cpp 在提交版本 7f4fbe51 时生成。

超越IMatrix的量化方法

正在测试一种新的量化方法,该方法使用规则将重要层的量化提升到标准IMatrix之上。标准的IMatrix在低比特量化和MOE模型中表现不佳,因此使用 llama.cpp --tensor-type 来提升选定层的量化。详情见 使用llama.cpp进行层提升。这种方法虽然会使模型文件变大,但能提高给定模型大小下的精度。

选择合适的模型格式

选择正确的模型格式取决于你的 硬件能力 和 内存限制。以下是不同模型格式的介绍:

- BF16(Brain Float 16):若硬件支持BF16加速,推荐使用。这是一种16位浮点格式,专为 更快的计算 设计,同时保留良好的精度。与FP32具有 相似的动态范围,但 内存使用更低。适用于 高性能推理,且与FP32相比,内存占用更小。

- 适用场景:硬件具有原生 BF16支持(如较新的GPU、TPU);希望在节省内存的同时获得 更高的精度;计划将模型重新量化为其他格式。

- 避免场景:硬件 不支持BF16(可能会回退到FP32并运行较慢);需要与缺乏BF16优化的旧设备兼容。

- F16(Float 16):比BF16更广泛支持。这是一种16位浮点格式,具有 高精度,但取值范围比BF16小。适用于大多数支持 FP16加速 的设备(包括许多GPU和一些CPU)。数值精度略低于BF16,但通常足以用于推理。

- 适用场景:硬件支持 FP16 但 不支持BF16;需要在 速度、内存使用和准确性 之间取得平衡;在 GPU 或其他针对FP16计算优化的设备上运行。

- 避免场景:设备缺乏 原生FP16支持(可能运行比预期慢);存在内存限制。

- 混合精度模型(如

bf16_q8_0、f16_q4_K):结合了全精度和量化的优点。这些格式选择性地 量化非关键层,同时保持 关键层的全精度(如注意力和输出层)。

- 适用场景:需要比仅量化模型 更高的准确性,但无法承受在所有地方使用全BF16/F16;设备支持 混合精度推理;希望在受限硬件上为生产级模型 优化权衡。

- 避免场景:目标设备 不支持混合或全精度加速;在 超严格的内存限制 下运行(此时应使用全量化格式)。

- 量化模型(Q4_K、Q6_K、Q8等):适用于CPU和低VRAM推理。量化可在尽可能保持准确性的同时减小模型大小和内存使用。

- 低比特模型(Q4_K):最适合 最小化内存使用,但可能精度较低。

- 高比特模型(Q6_K、Q8_0):准确性更好,但需要更多内存。

- 适用场景:在 CPU 上运行推理并需要优化模型;设备具有 低VRAM 且无法加载全精度模型;希望在保持合理准确性的同时减少 内存占用。

- 避免场景:需要 最高准确性(全精度模型更适合);硬件有足够的VRAM用于更高精度的格式(BF16/F16)。

- 极低比特量化(IQ3_XS、IQ3_S、IQ3_M、Q4_K、Q4_0):这些模型针对 非常高的内存效率 进行了优化,适用于 低功耗设备 或 大规模部署,其中内存是关键限制因素。

- IQ3_XS:超低位量化(3位),具有 非常高的内存效率。适用于 超低内存设备,即使Q4_K也太大的情况。但与高比特量化相比,准确性较低。

- IQ3_S:小块大小,实现 最大内存效率。适用于 低内存设备,当IQ3_XS过于激进时使用。

- IQ3_M:中等块大小,比IQ3_S 准确性更好。适用于 低内存设备,当IQ3_S限制过多时使用。

- Q4_K:4位量化,具有 逐块优化 以提高准确性。适用于 低内存设备,当Q6_K太大时使用。

- Q4_0:纯4位量化,针对 ARM设备 进行了优化。适用于 基于ARM的设备 或 低内存环境。

- 超低比特量化(IQ1_S、IQ1_M、IQ2_S、IQ2_M、IQ2_XS、IQ2_XSS):超低位量化(1 - 2位),具有 极高的内存效率。适用于必须将模型装入非常受限内存的情况,但准确性非常低,使用前请充分测试。

模型格式选择总结表

| 属性 |

详情 |

| 模型格式 |

BF16、F16、Q4_K、Q6_K、Q8_0、IQ3_XS、IQ3_S、IQ3_M、Q4_0、超低比特(IQ1/2_*)、混合(如 bf16_q8_0) |

| 精度 |

非常高、高、中低、中、高、低、低、低 - 中、低、非常低、中 - 高 |

| 内存使用 |

高、高、低、中等、中等、非常低、非常低、低、低、极低、中等 |

| 设备要求 |

支持BF16的GPU/CPU、支持FP16的GPU/CPU、CPU或低VRAM设备、有更多内存的CPU、有中等VRAM的GPU/CPU、超低内存设备、低内存设备、低内存设备、基于ARM/嵌入式设备、微小边缘/嵌入式设备、支持混合精度的硬件 |

| 最佳用例 |

高速推理且内存减少、BF16不可用时的推理、内存受限的推理、量化时更好的准确性、量化模型中最高的准确性、最大内存效率,低准确性、比IQ3_XS更实用、比IQ3_S准确性更好、Llama.cpp自动为ARM推理优化、将模型装入极紧的内存,低准确性、平衡性能和内存,关键层接近FP准确性 |

Qwen2.5-Omni概述

Qwen2.5-Omni是一个端到端的多模态模型,旨在感知多种模态,包括文本、图像、音频和视频,同时以流式方式生成文本和自然语音响应。

关键特性

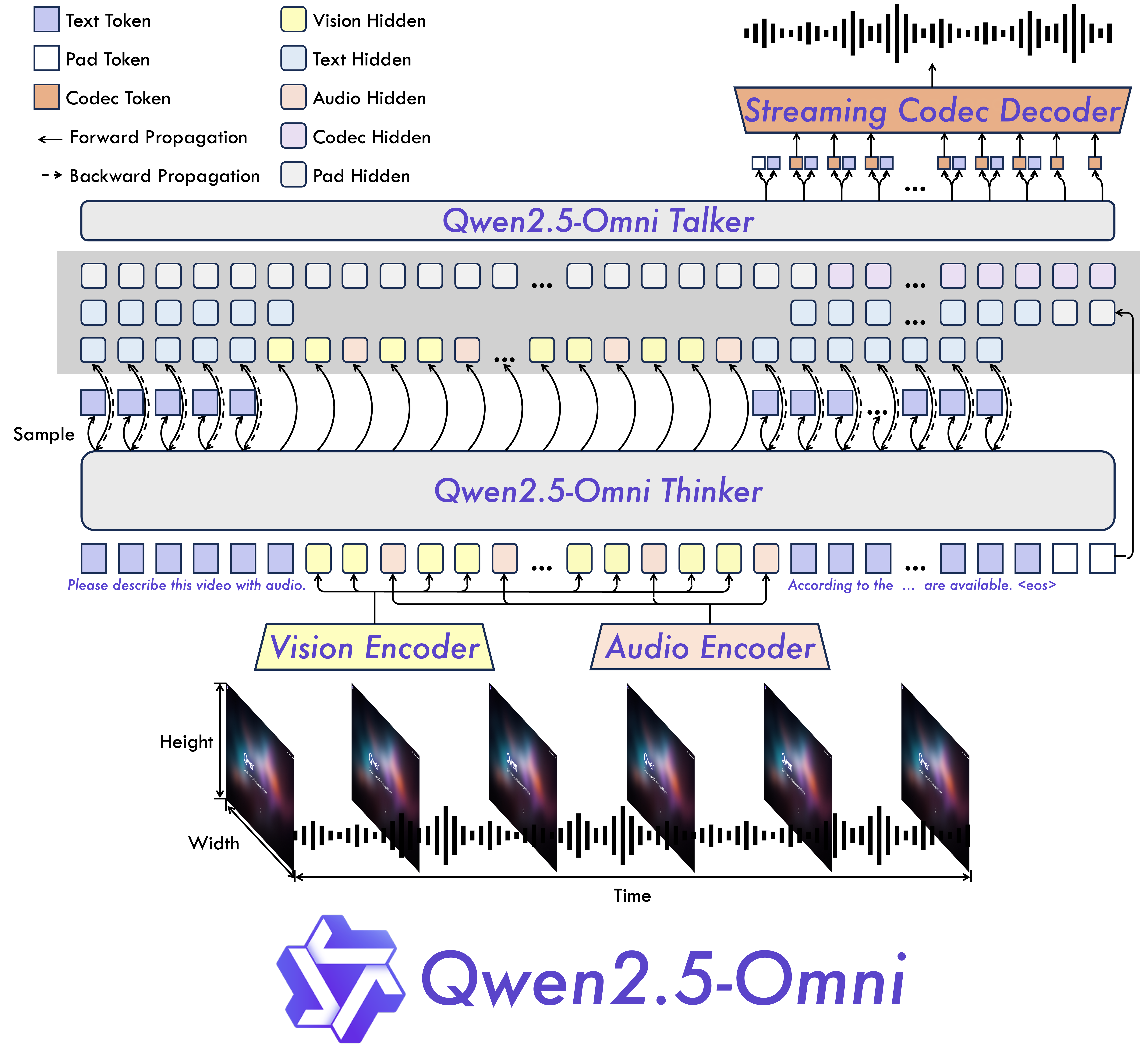

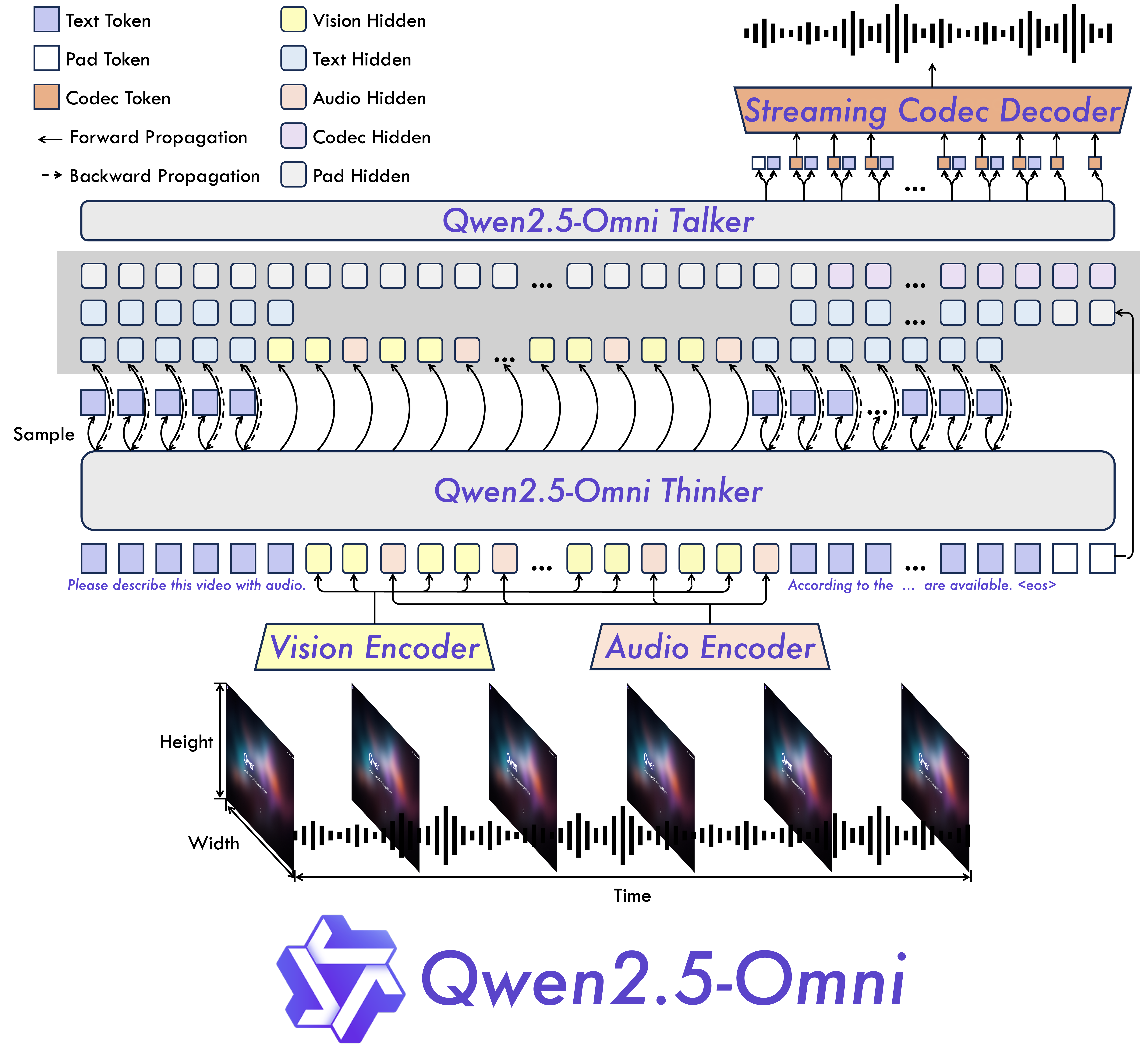

- 全功能和新颖架构:提出了Thinker - Talker架构,这是一个端到端的多模态模型,能够感知多种模态,包括文本、图像、音频和视频,同时以流式方式生成文本和自然语音响应。还提出了一种新颖的位置嵌入,名为TMRoPE(时间对齐的多模态RoPE),用于同步视频输入和音频的时间戳。

- 实时语音和视频聊天:架构设计用于完全实时交互,支持分块输入和即时输出。

- 自然而强大的语音生成:在语音生成方面超越了许多现有的流式和非流式替代方案,表现出卓越的鲁棒性和自然度。

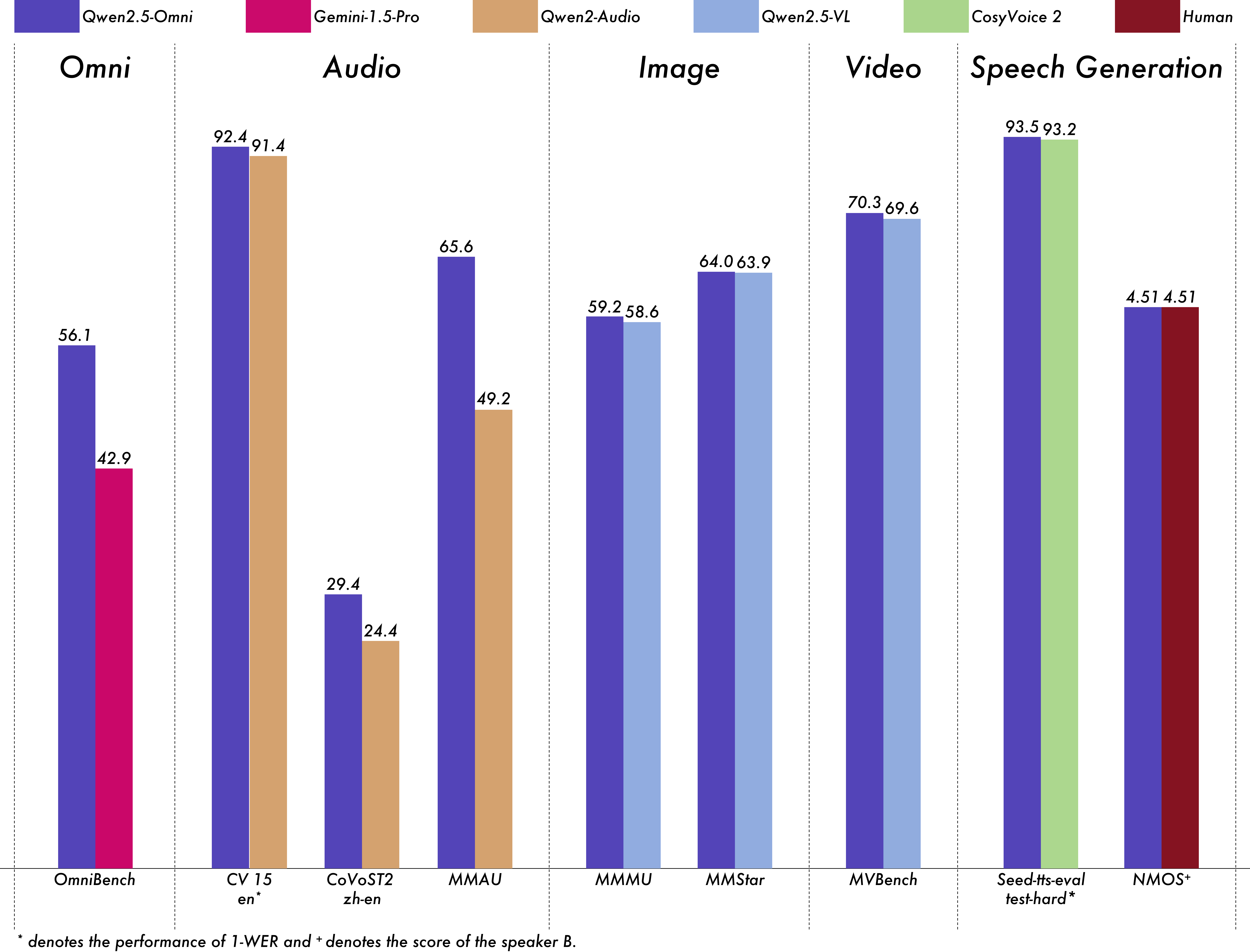

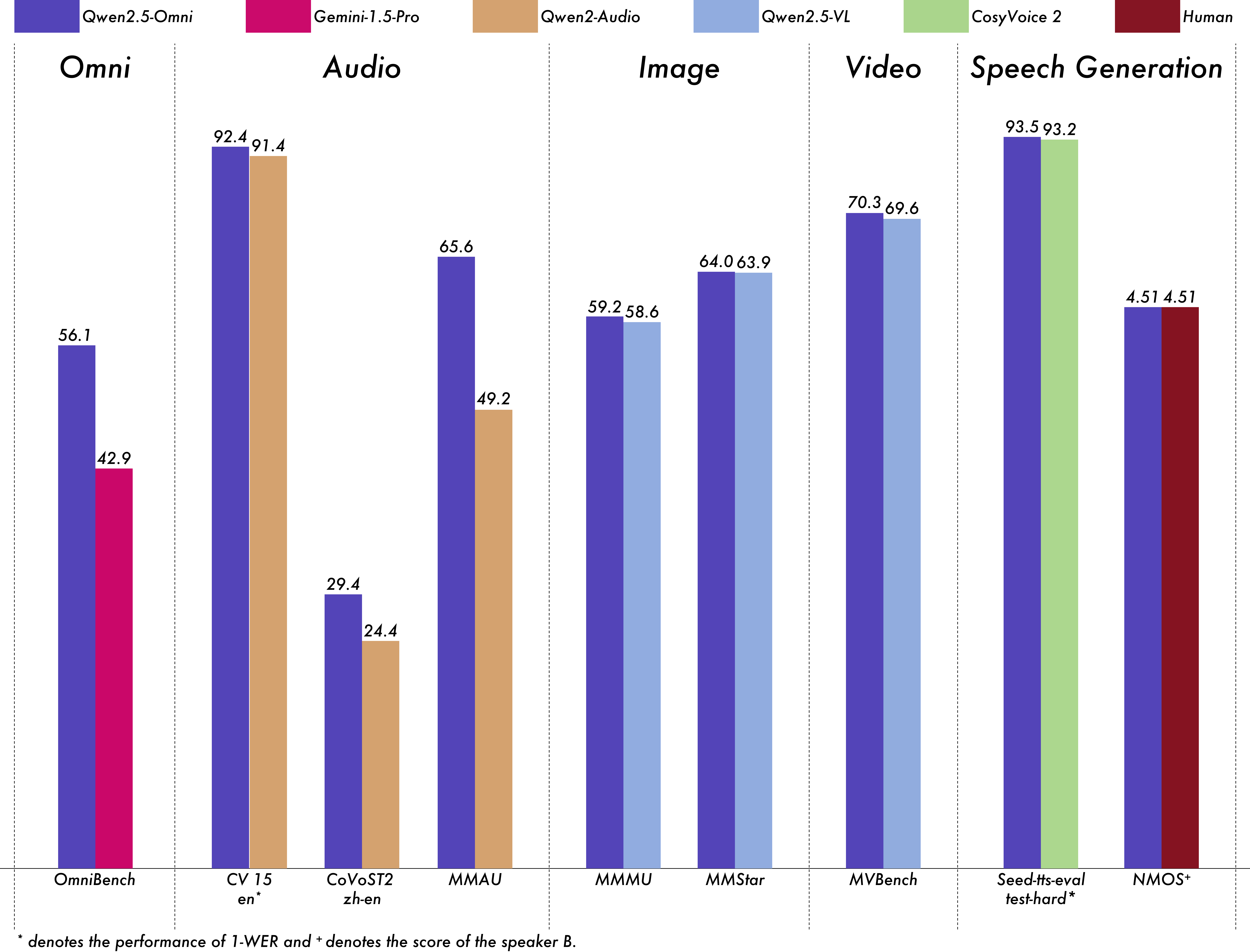

- 跨模态的强大性能:与类似规模的单模态模型相比,在所有模态上都表现出卓越的性能。Qwen2.5-Omni在音频能力上优于类似规模的Qwen2 - Audio,并达到了与Qwen2.5 - VL - 7B相当的性能。

- 出色的端到端语音指令遵循:Qwen2.5-Omni在端到端语音指令遵循方面的表现与其在文本输入时的效果相当,如MMLU和GSM8K等基准测试所示。

模型架构

性能

对Qwen2.5-Omni进行了全面评估,与类似规模的单模态模型和闭源模型(如Qwen2.5 - VL - 7B、Qwen2 - Audio和Gemini - 1.5 - pro)相比,它在所有模态上都表现出强大的性能。在需要整合多种模态的任务中,如OmniBench,Qwen2.5-Omni达到了最先进的性能。此外,在单模态任务中,它在语音识别(Common Voice)、翻译(CoVoST2)、音频理解(MMAU)、图像推理(MMMU、MMStar)、视频理解(MVBench)和语音生成(Seed - tts - eval和主观自然度)等方面表现出色。

多模态 -> 文本

| 数据集 |

模型 |

性能 |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

Gemini - 1.5 - Pro |

42.67%|42.26%|46.23%|42.91% |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

MIO - Instruct |

36.96%|33.58%|11.32%|33.80% |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

AnyGPT (7B) |

17.77%|20.75%|13.21%|18.04% |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

video - SALMONN |

34.11%|31.70%|56.60%|35.64% |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

UnifiedIO2 - xlarge |

39.56%|36.98%|29.25%|38.00% |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

UnifiedIO2 - xxlarge |

34.24%|36.98%|24.53%|33.98% |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

MiniCPM - o |

- |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

Baichuan - Omni - 1.5 |

- |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

Qwen2.5 - Omni - 3B |

52.14%|52.08%|52.83%|52.19% |

OmniBench

语音 | 声音事件 | 音乐 | 平均 |

Qwen2.5 - Omni - 7B |

55.25%|60.00%|52.83%|56.13% |

音频 -> 文本

| 数据集 |

模型 |

性能 |

| 语音识别(ASR) |

|

|

Librispeech

dev - clean | dev other | test - clean | test - other |

SALMONN |

- |

Librispeech

dev - clean | dev other | test - clean | test - other |

SpeechVerse |

- |

Librispeech

dev - clean | dev other | test - clean | test - other |

Whisper - large - v3 |

- |

Librispeech

dev - clean | dev other | test - clean | test - other |

Llama - 3 - 8B |

- |

Librispeech

dev - clean | dev other | test - clean | test - other |

Llama - 3 - 70B |

- |

Librispeech

dev - clean | dev other | test - clean | test - other |

Seed - ASR - Multilingual |

- |

Librispeech

dev - clean | dev other | test - clean | test - other |

MiniCPM - o |

- |

Librispeech

dev - clean | dev other | test - clean | test - other |

MinMo |

- |

Librispeech

dev - clean | dev other | test - clean | test - other |

Qwen - Audio |

1.8 |

Librispeech

dev - clean | dev other | test - clean | test - other |

Qwen2 - Audio |

1.3 |

Librispeech

dev - clean | dev other | test - clean | test - other |

Qwen2.5 - Omni - 3B |

2.0 |

Librispeech

dev - clean | dev other | test - clean | test - other |

Qwen2.5 - Omni - 7B |

1.6 |

Common Voice 15

en | zh | yue | fr |

Whisper - large - v3 |

9.3 |

Common Voice 15

en | zh | yue | fr |

MinMo |

7.9 |

Common Voice 15

en | zh | yue | fr |

Qwen2 - Audio |

8.6 |

Common Voice 15

en | zh | yue | fr |

Qwen2.5 - Omni - 3B |

9.1 |

Common Voice 15

en | zh | yue | fr |

Qwen2.5 - Omni - 7B |

7.6 |

Fleurs

zh | en |

Whisper - large - v3 |

7.7 |

Fleurs

zh | en |

Seed - ASR - Multilingual |

- |

Fleurs

zh | en |

Megrez - 3B - Omni |

10.8 |

Fleurs

zh | en |

MiniCPM - o |

4.4 |

Fleurs

zh | en |

MinMo |

3.0 |

Fleurs

zh | en |

Qwen2 - Audio |

7.5 |

Fleurs

zh | en |

Qwen2.5 - Omni - 3B |

3.2 |

Fleurs

zh | en |

Qwen2.5 - Omni - 7B |

3.0 |

Wenetspeech

test - net | test - meeting |

Seed - ASR - Chinese |

4.7|5.7 |

Wenetspeech

test - net | test - meeting |

Megrez - 3B - Omni |

- |

Wenetspeech

test - net | test - meeting |

MiniCPM - o |

6.9 |

Wenetspeech

test - net | test - meeting |

MinMo |

6.8 |

Wenetspeech

test - net | test - meeting |

Qwen2.5 - Omni - 3B |

6.3 |

Wenetspeech

test - net | test - meeting |

Qwen2.5 - Omni - 7B |

5.9 |

| Voxpopuli - V1.0 - en |

Llama - 3 - 8B |

6.2 |

| Voxpopuli - V1.0 - en |

Llama - 3 - 70B |

5.7 |

| Voxpopuli - V1.0 - en |

Qwen2.5 - Omni - 3B |

6.6 |

| Voxpopuli - V1.0 - en |

Qwen2.5 - Omni - 7B |

5.8 |

| 语音到文本翻译(S2TT) |

|

|

CoVoST2

en - de | de - en | en - zh | zh - en |

SALMONN |

18.6 |

CoVoST2

en - de | de - en | en - zh | zh - en |

SpeechLLaMA |

- |

CoVoST2

en - de | de - en | en - zh | zh - en |

BLSP |

14.1 |

CoVoST2

en - de | de - en | en - zh | zh - en |

MiniCPM - o |

- |

CoVoST2

en - de | de - en | en - zh | zh - en |

MinMo |

- |

CoVoST2

en - de | de - en | en - zh | zh - en |

Qwen - Audio |

25.1 |

CoVoST2

en - de | de - en | en - zh | zh - en |

Qwen2 - Audio |

29.9 |

CoVoST2

en - de | de - en | en - zh | zh - en |

Qwen2.5 - Omni - 3B |

28.3 |

CoVoST2

en - de | de - en | en - zh | zh - en |

Qwen2.5 - Omni - 7B |

30.2 |

| 语音情感识别(SER) |

|

|

| Meld |

WavLM - large |

0.542 |

| Meld |

MiniCPM - o |

0.524 |

| Meld |

Qwen - Audio |

0.557 |

| Meld |

Qwen2 - Audio |

0.553 |

| Meld |

Qwen2.5 - Omni - 3B |

0.558 |

| Meld |

Qwen2.5 - Omni - 7B |

0.570 |

| 语音声音分类(VSC) |

|

|

| VocalSound |

CLAP |

0.495 |

| VocalSound |

Pengi |

0.604 |

| VocalSound |

Qwen - Audio |

0.929 |

| VocalSound |

Qwen2 - Audio |

0.939 |

| VocalSound |

Qwen2.5 - Omni - 3B |

0.936 |

| VocalSound |

Qwen2.5 - Omni - 7B |

0.939 |

| 音乐 |

|

|

| GiantSteps Tempo |

Llark - 7B |

0.86 |

| GiantSteps Tempo |

Qwen2.5 - Omni - 3B |

0.88 |

📄 许可证

本项目采用 qwen-research 许可证。

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语