🚀 Swin Transformer v2(基础尺寸模型)

Swin Transformer v2是一个在图像分类领域表现出色的模型。它先在ImageNet - 21k数据集上进行预训练,再在分辨率为384x384的ImageNet - 1k数据集上进行微调,能够高效准确地完成图像分类任务。

🚀 快速开始

你可以使用这个原始模型进行图像分类。若想寻找在特定任务上微调过的版本,可查看模型中心。

以下是如何使用该模型将COCO 2017数据集中的图像分类为1000个ImageNet类别之一的示例:

from transformers import AutoImageProcessor, AutoModelForImageClassification

from PIL import Image

import requests

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

processor = AutoImageProcessor.from_pretrained("microsoft/swinv2-base-patch4-window12to24-192to384-22kto1k-ft")

model = AutoModelForImageClassification.from_pretrained("microsoft/swinv2-base-patch4-window12to24-192to384-22kto1k-ft")

inputs = processor(images=image, return_tensors="pt")

outputs = model(**inputs)

logits = outputs.logits

predicted_class_idx = logits.argmax(-1).item()

print("Predicted class:", model.config.id2label[predicted_class_idx])

更多代码示例,请参考文档。

✨ 主要特性

模型基础特性

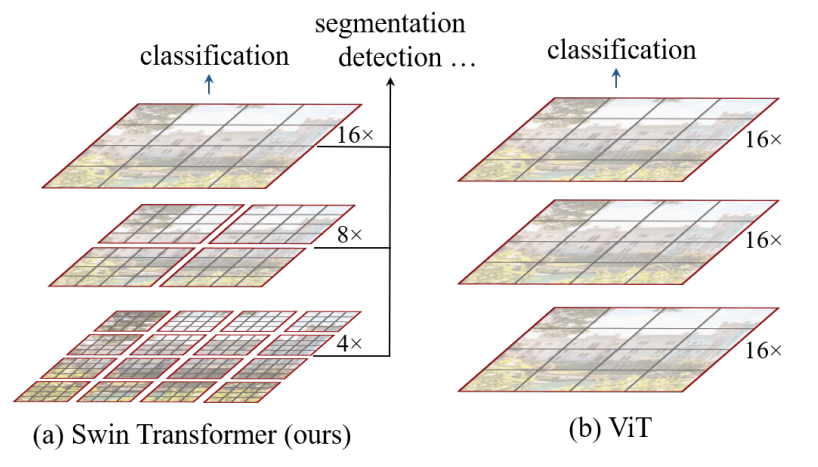

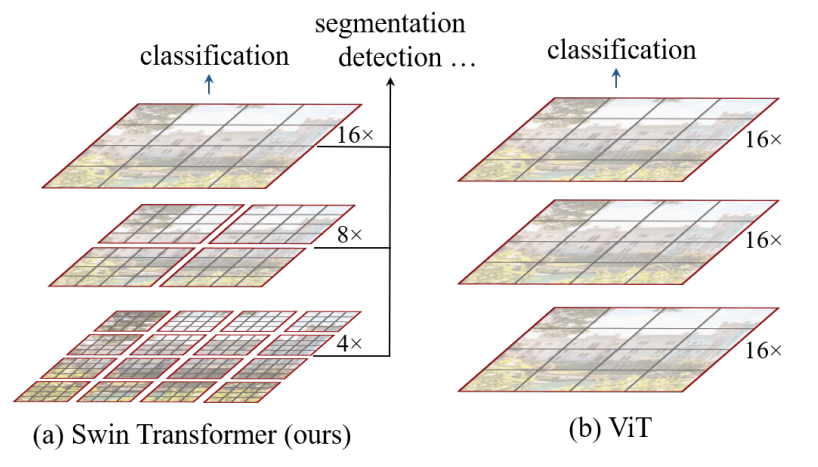

Swin Transformer是一种视觉Transformer。它通过在更深的层中合并图像块(灰色部分)来构建分层特征图,并且由于仅在每个局部窗口(红色部分)内计算自注意力,因此对输入图像大小具有线性计算复杂度。这使得它既可以作为图像分类的主干网络,也适用于密集识别任务。而之前的视觉Transformer只能生成单一低分辨率的特征图,并且由于全局计算自注意力,对输入图像大小具有二次计算复杂度。

Swin Transformer v2的改进

- 训练稳定性提升:采用残差后归一化方法与余弦注意力相结合,提高了训练的稳定性。

- 跨分辨率迁移能力增强:使用对数间隔连续位置偏置方法,能有效地将使用低分辨率图像预训练的模型迁移到高分辨率输入的下游任务中。

- 减少标注数据依赖:引入自监督预训练方法SimMIM,降低了对大量标注图像的需求。

来源

来源

📚 详细文档

模型描述

Swin Transformer v2模型先在ImageNet - 21k数据集上预训练,然后在分辨率为384x384的ImageNet - 1k数据集上进行微调。该模型由Liu等人在论文Swin Transformer V2: Scaling Up Capacity and Resolution中提出,并首次在[此仓库](https://github.com/microsoft/Swin - Transformer)中发布。

需要说明的是,发布Swin Transformer v2的团队并未为此模型编写模型卡片,此模型卡片由Hugging Face团队编写。

预期用途和局限性

该模型可用于图像分类任务。

BibTeX引用和引用信息

@article{DBLP:journals/corr/abs-2111-09883,

author = {Ze Liu and

Han Hu and

Yutong Lin and

Zhuliang Yao and

Zhenda Xie and

Yixuan Wei and

Jia Ning and

Yue Cao and

Zheng Zhang and

Li Dong and

Furu Wei and

Baining Guo},

title = {Swin Transformer {V2:} Scaling Up Capacity and Resolution},

journal = {CoRR},

volume = {abs/2111.09883},

year = {2021},

url = {https://arxiv.org/abs/2111.09883},

eprinttype = {arXiv},

eprint = {2111.09883},

timestamp = {Thu, 02 Dec 2021 15:54:22 +0100},

biburl = {https://dblp.org/rec/journals/corr/abs-2111-09883.bib},

bibsource = {dblp computer science bibliography, https://dblp.org}

}

📄 许可证

本模型采用Apache - 2.0许可证。

| 属性 |

详情 |

| 模型类型 |

视觉Transformer,用于图像分类 |

| 训练数据 |

ImageNet - 21k预训练,ImageNet - 1k微调 |

| 标签 |

视觉、图像分类 |

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语