🚀 具有ResNet - 50主干的可变形DETR模型,单尺度+膨胀

可变形检测变压器(Deformable DETR)单尺度 + 膨胀模型在COCO 2017目标检测数据集(11.8万张带注释的图像)上进行了端到端训练。该模型由Zhu等人在论文Deformable DETR: Deformable Transformers for End - to - End Object Detection中提出,并首次在[此仓库](https://github.com/fundamentalvision/Deformable - DETR)中发布。

声明:发布可变形DETR的团队并未为此模型撰写模型卡片,此模型卡片由Hugging Face团队撰写。

🚀 快速开始

可变形DETR模型可直接用于目标检测任务。你可以在[模型中心](https://huggingface.co/models?search=sensetime/deformable - detr)查找所有可用的可变形DETR模型。

✨ 主要特性

- 端到端训练:在COCO 2017目标检测数据集上进行端到端训练,无需复杂的后处理步骤。

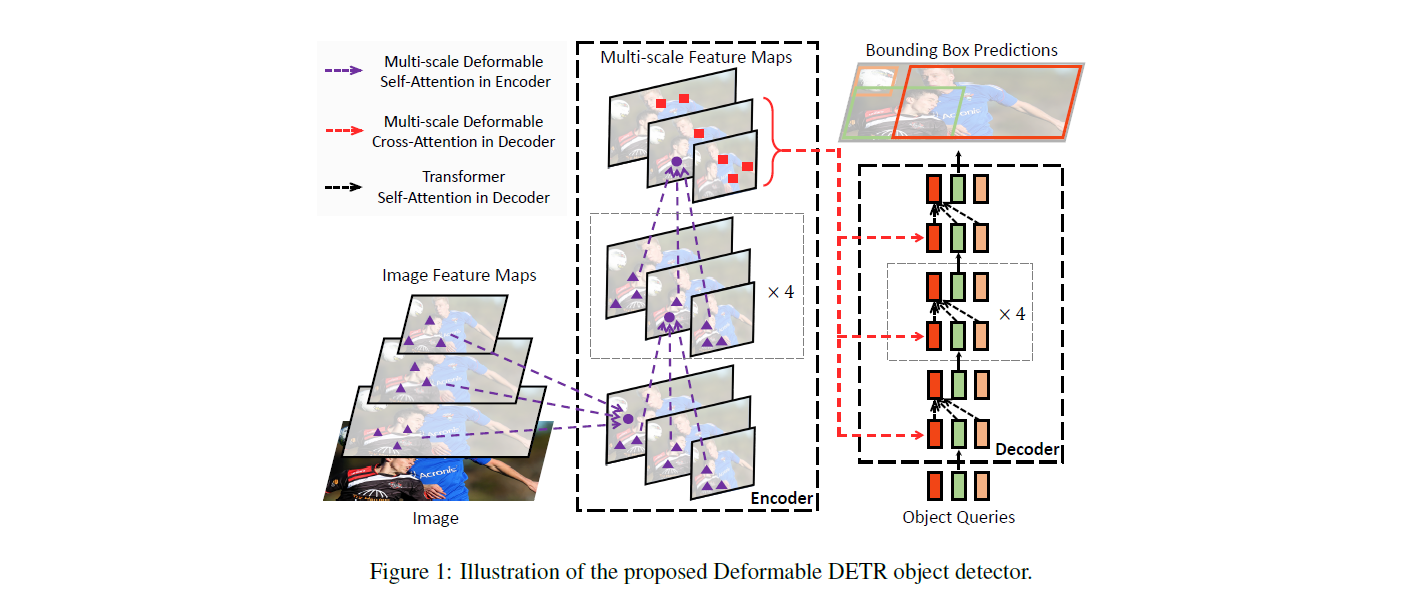

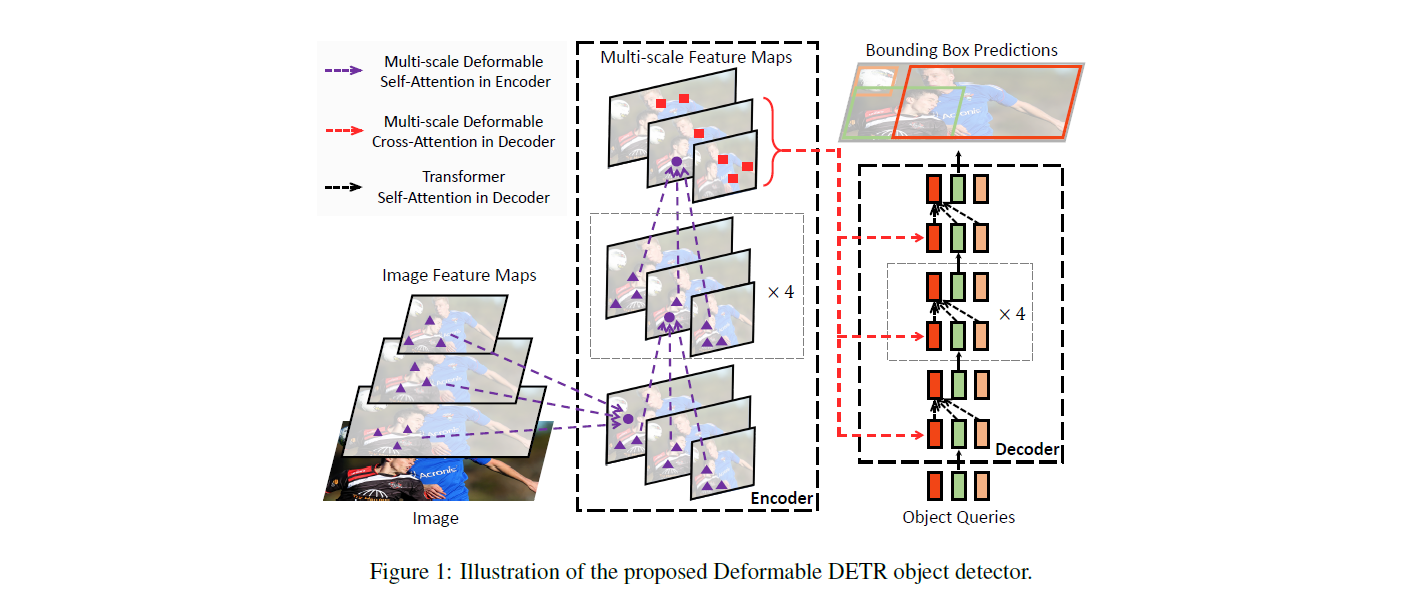

- 基于Transformer架构:采用编码器 - 解码器的Transformer架构,结合卷积主干网络,提升目标检测性能。

- 对象查询机制:使用对象查询来检测图像中的对象,每个对象查询针对图像中的特定对象。

📚 详细文档

模型描述

DETR模型是一个带有卷积主干的编码器 - 解码器Transformer。为了进行目标检测,在解码器输出的基础上添加了两个头部:一个用于类别标签的线性层和一个用于边界框的多层感知机(MLP)。该模型使用所谓的对象查询来检测图像中的对象,对于COCO数据集,对象查询的数量设置为100。

模型使用“二分匹配损失”进行训练:将N = 100个对象查询的预测类别和边界框与真实标注进行比较,真实标注会填充到相同的长度N(因此,如果一张图像只包含4个对象,那么96个标注的类别将为“无对象”,边界框为“无边界框”)。使用匈牙利匹配算法在N个查询和N个标注之间创建最优的一对一映射。接下来,使用标准交叉熵(用于类别)和L1损失与广义IoU损失的线性组合(用于边界框)来优化模型的参数。

预期用途和限制

你可以使用该原始模型进行目标检测。

使用示例

基础用法

from transformers import AutoImageProcessor, DeformableDetrForObjectDetection

import torch

from PIL import Image

import requests

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

processor = AutoImageProcessor.from_pretrained("SenseTime/deformable-detr-single-scale-dc5")

model = DeformableDetrForObjectDetection.from_pretrained("SenseTime/deformable-detr-single-scale-dc5")

inputs = processor(images=image, return_tensors="pt")

outputs = model(**inputs)

target_sizes = torch.tensor([image.size[::-1]])

results = processor.post_process_object_detection(outputs, target_sizes=target_sizes, threshold=0.7)[0]

for score, label, box in zip(results["scores"], results["labels"], results["boxes"]):

box = [round(i, 2) for i in box.tolist()]

print(

f"Detected {model.config.id2label[label.item()]} with confidence "

f"{round(score.item(), 3)} at location {box}"

)

目前,特征提取器和模型都支持PyTorch。

训练数据

可变形DETR模型在COCO 2017目标检测数据集上进行训练,该数据集分别包含11.8万张和5000张用于训练和验证的带注释图像。

BibTeX引用和引用信息

@misc{https://doi.org/10.48550/arxiv.2010.04159,

doi = {10.48550/ARXIV.2010.04159},

url = {https://arxiv.org/abs/2010.04159},

author = {Zhu, Xizhou and Su, Weijie and Lu, Lewei and Li, Bin and Wang, Xiaogang and Dai, Jifeng},

keywords = {Computer Vision and Pattern Recognition (cs.CV), FOS: Computer and information sciences, FOS: Computer and information sciences},

title = {Deformable DETR: Deformable Transformers for End-to-End Object Detection},

publisher = {arXiv},

year = {2020},

copyright = {arXiv.org perpetual, non-exclusive license}

}

📄 许可证

本项目采用Apache - 2.0许可证。

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语