🚀 SigLIP (形状优化模型)

SigLIP是一种多模态模型,它改进了损失函数,可用于零样本图像分类和图像 - 文本检索等任务,在图像相关任务上表现出色。

🚀 快速开始

你可以使用这个原始模型进行零样本图像分类和图像 - 文本检索等任务。可查看模型中心,寻找你感兴趣的其他版本。

✨ 主要特性

- SigLIP是CLIP的改进版,采用了更好的损失函数。

- 其使用的sigmoid损失仅在图像 - 文本对上操作,无需对成对相似性进行全局归一化,可进一步扩大批量大小,且在小批量时也表现良好。

📦 安装指南

文档未提及具体安装步骤,可参考transformers库的安装方式。

💻 使用示例

基础用法

from PIL import Image

import requests

from transformers import AutoProcessor, AutoModel

import torch

model = AutoModel.from_pretrained("google/siglip-so400m-patch14-224")

processor = AutoProcessor.from_pretrained("google/siglip-so400m-patch14-224")

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

texts = ["a photo of 2 cats", "a photo of 2 dogs"]

inputs = processor(text=texts, images=image, padding="max_length", return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = torch.sigmoid(logits_per_image)

print(f"{probs[0][0]:.1%} that image 0 is '{texts[0]}'")

高级用法

from transformers import pipeline

from PIL import Image

import requests

image_classifier = pipeline(task="zero-shot-image-classification", model="google/siglip-so400m-patch14-224")

url = 'http://images.cocodataset.org/val2017/000000039769.jpg'

image = Image.open(requests.get(url, stream=True).raw)

outputs = image_classifier(image, candidate_labels=["2 cats", "a plane", "a remote"])

outputs = [{"score": round(output["score"], 4), "label": output["label"] } for output in outputs]

print(outputs)

更多代码示例可参考文档。

📚 详细文档

模型描述

SigLIP是一种多模态模型,它改进了CLIP的损失函数。sigmoid损失仅在图像 - 文本对上操作,无需对成对相似性进行全局归一化,这使得在进一步扩大批量大小的同时,在小批量时也能有更好的表现。一位作者对SigLIP的简要总结可在此处找到。

预期用途和局限性

可使用原始模型进行零样本图像分类和图像 - 文本检索等任务。可查看模型中心,寻找你感兴趣的其他版本。

训练过程

训练数据

SigLIP在WebLI数据集(Chen et al., 2023)上进行预训练。

预处理

- 图像被调整大小/重新缩放至相同分辨率(384x384),并在RGB通道上进行归一化,均值为(0.5, 0.5, 0.5),标准差为(0.5, 0.5, 0.5)。

- 文本被分词并填充至相同长度(64个标记)。

计算资源

该模型在16个TPU - v4芯片上训练了三天。

评估结果

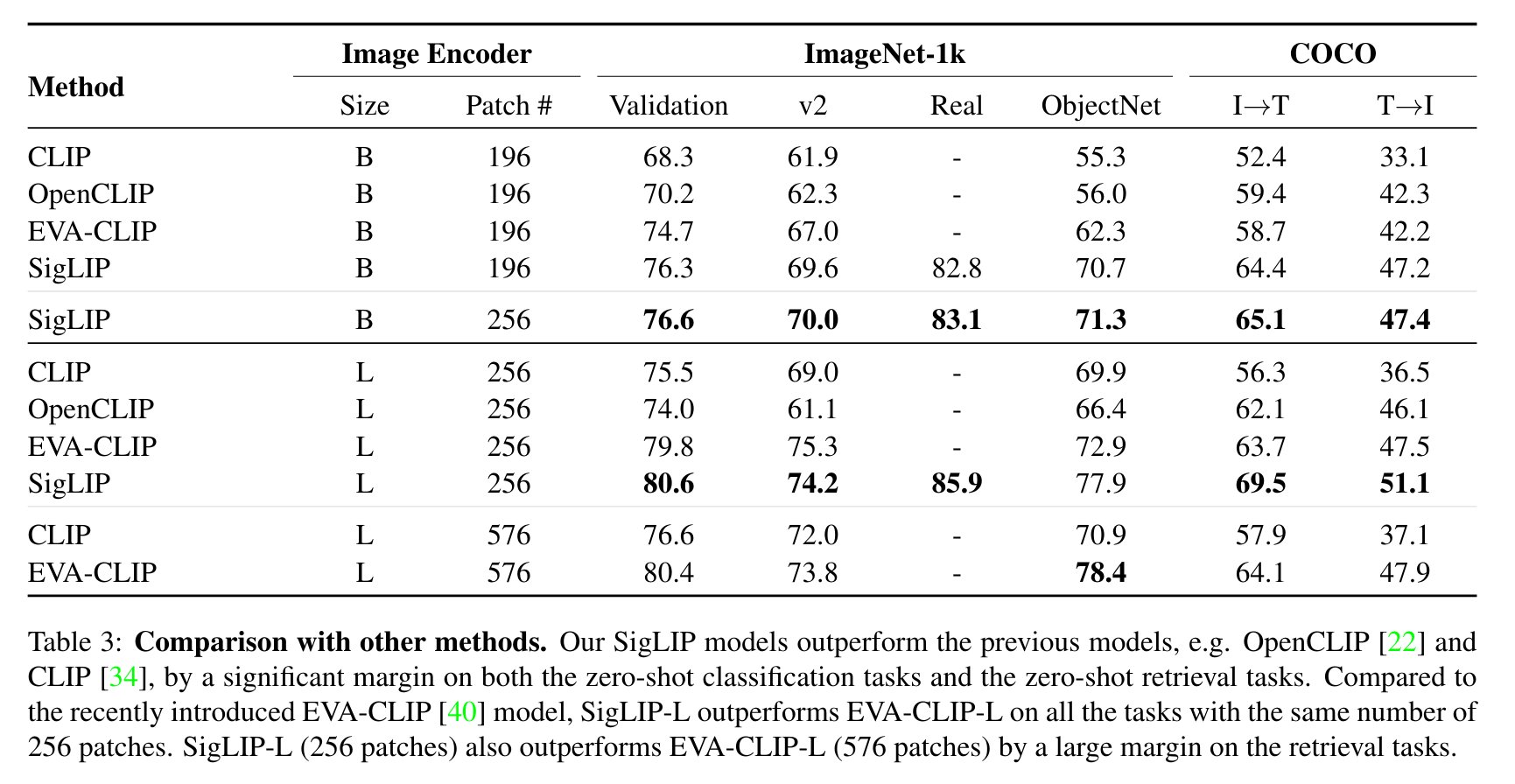

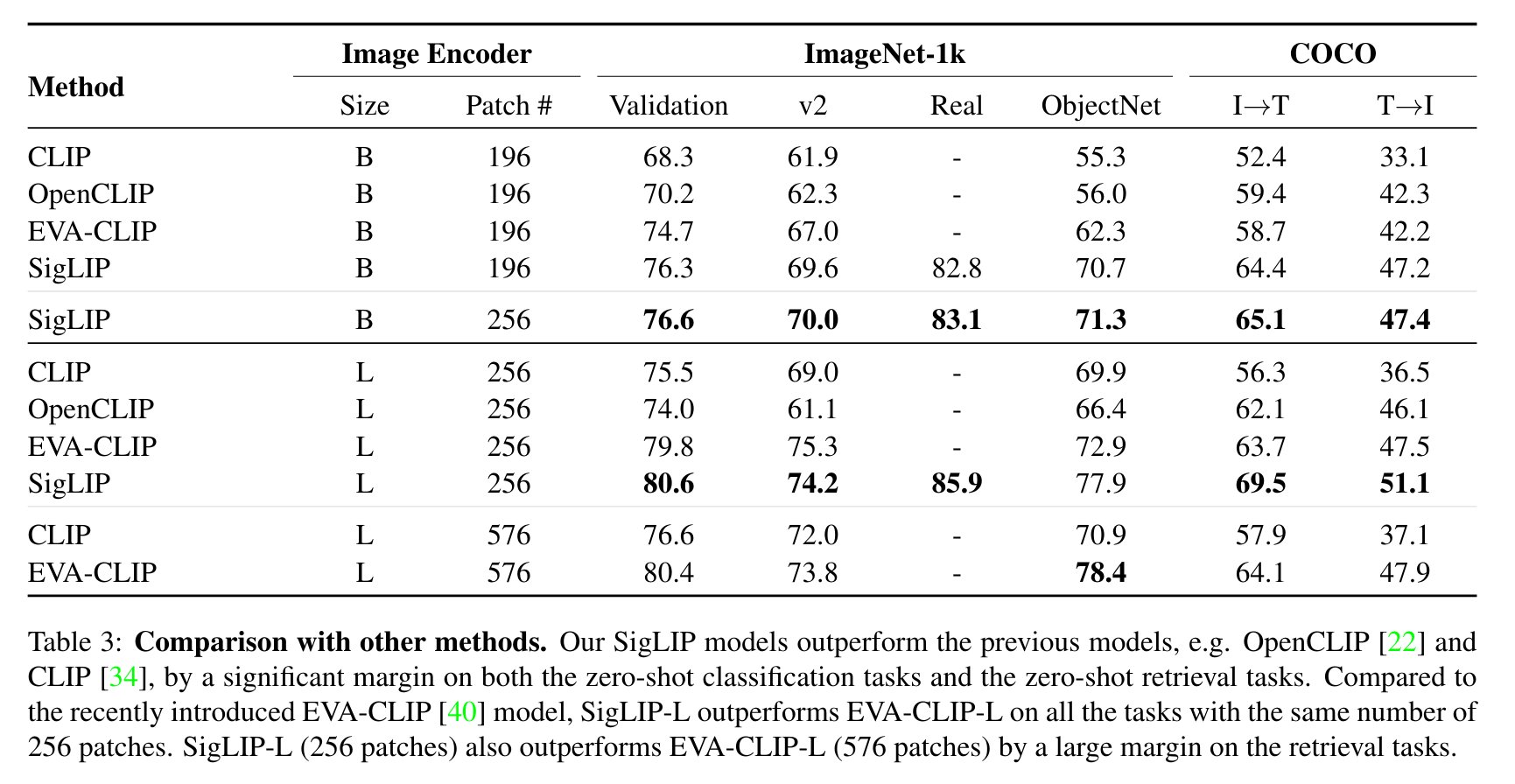

SigLIP与CLIP的评估对比结果如下(取自论文):

BibTeX引用

@misc{zhai2023sigmoid,

title={Sigmoid Loss for Language Image Pre-Training},

author={Xiaohua Zhai and Basil Mustafa and Alexander Kolesnikov and Lucas Beyer},

year={2023},

eprint={2303.15343},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

🔧 技术细节

SigLIP模型在分辨率为224x224的WebLi上进行预训练。它由Zhai等人在论文Sigmoid Loss for Language Image Pre-Training中提出,并首次在此仓库发布。该模型采用SoViT - 400m架构,这是Alabdulmohsin等人在Getting ViT in Shape: Scaling Laws for Compute-Optimal Model Design中提出的形状优化版本。

📄 许可证

本模型使用Apache - 2.0许可证。

⚠️ 重要提示

发布SigLIP的团队未为此模型编写模型卡片,此模型卡片由Hugging Face团队编写。

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语