🚀 mxbai-embed-large-v1-gguf

本项目提供了 mxbai-embed-large-v1 模型的 GGUF 格式文件,可用于特征提取,在 BERT 大规模模型上实现了 SOTA 性能。

🚀 快速开始

与 llama.cpp 结合使用示例

若要计算单个嵌入向量,需先构建 llama.cpp 并运行以下命令:

./embedding -ngl 99 -m [filepath-to-gguf].gguf -p 'search_query: What is TSNE?'

你也可以提交一批文本进行嵌入处理,只要总令牌数不超过上下文长度即可。embedding 示例仅展示前三个嵌入向量。

texts.txt 文件内容如下:

search_query: What is TSNE?

search_query: Who is Laurens Van der Maaten?

计算多个嵌入向量的命令如下:

./embedding -ngl 99 -m [filepath-to-gguf].gguf -f texts.txt

与 LM Studio 结合使用示例

从以下链接下载 0.2.19 测试版:Windows MacOS Linux

安装完成后,打开应用程序。主界面应如下所示:

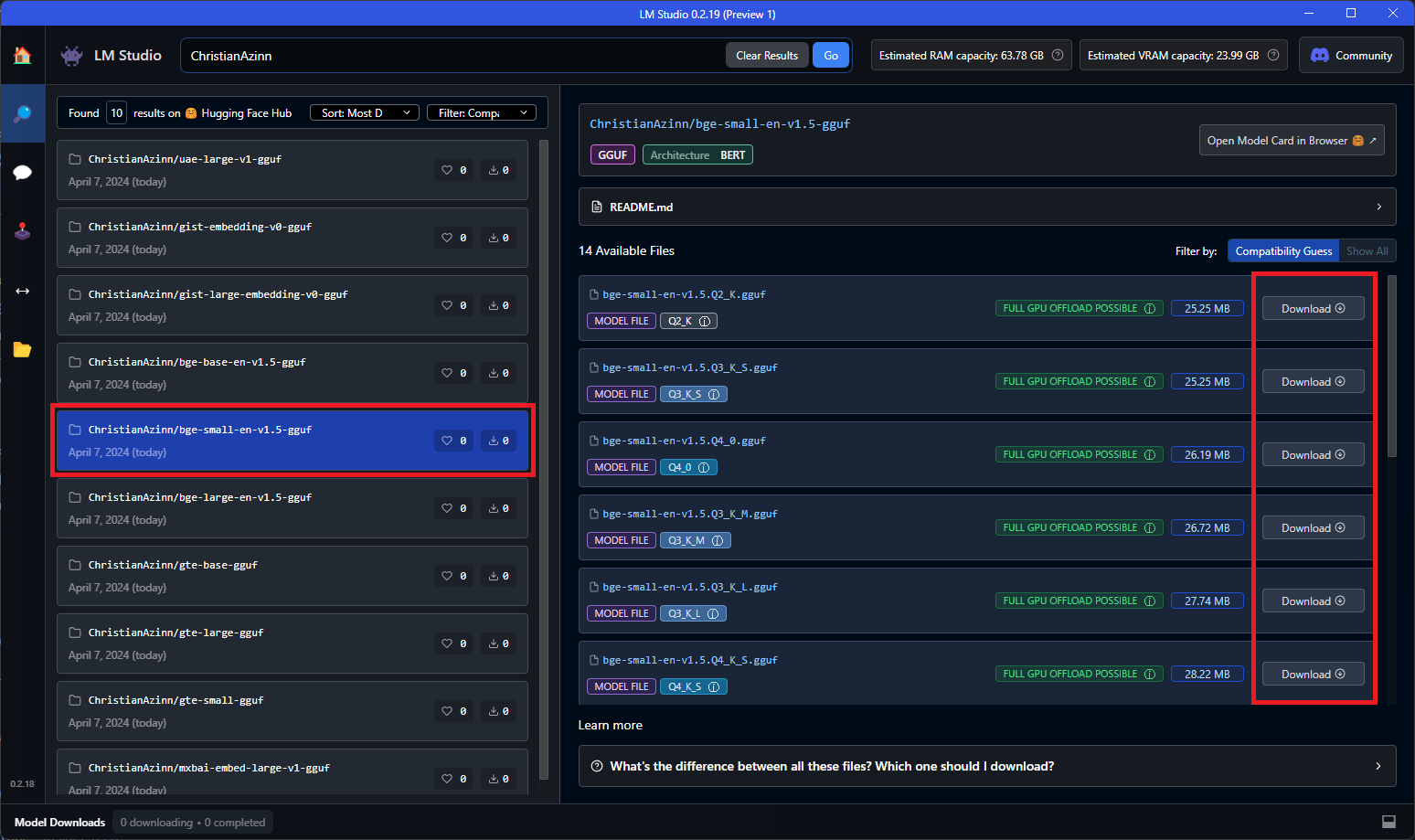

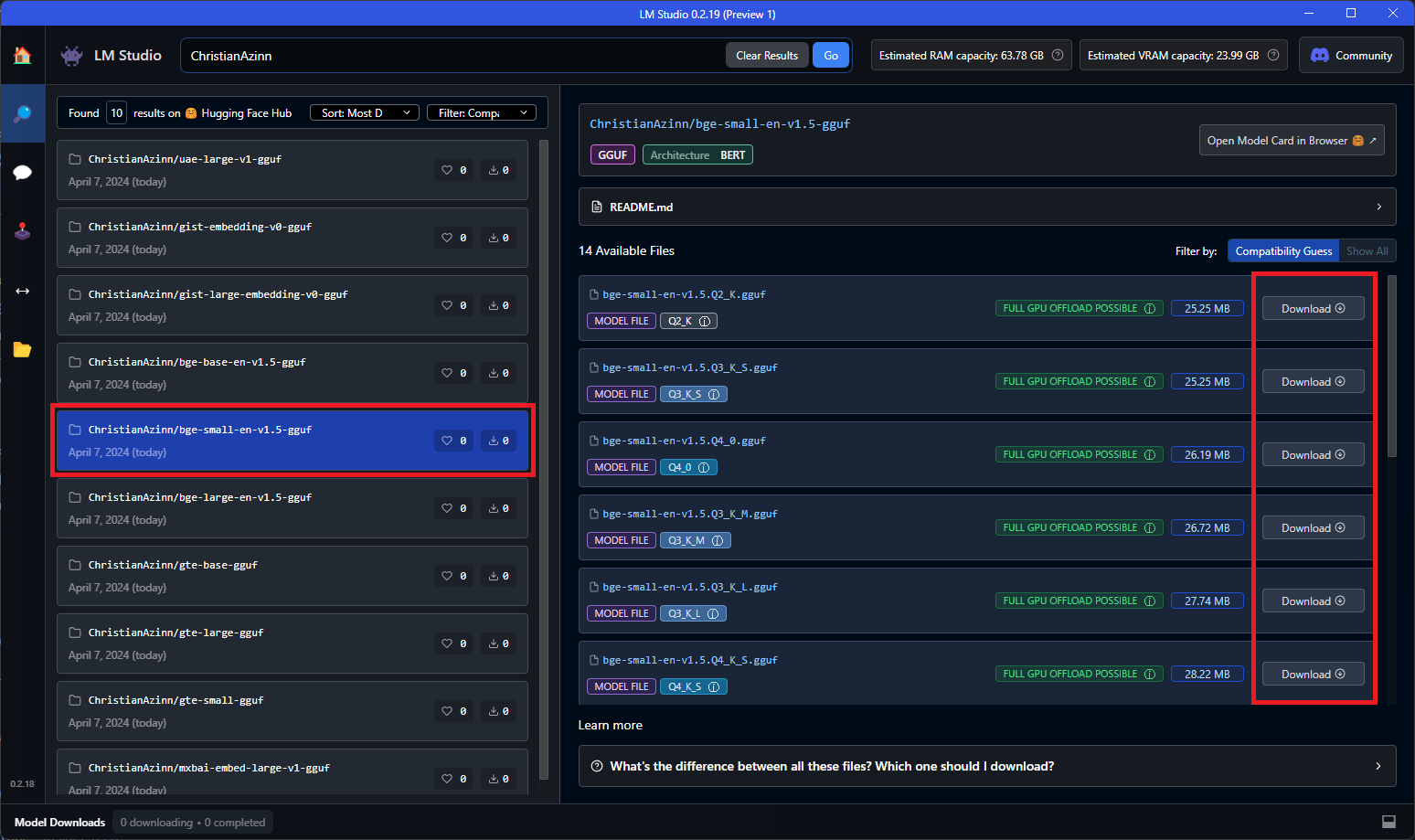

在主搜索栏中搜索 “ChristianAzinn”,或者点击左侧菜单中的 “搜索” 标签进行搜索。

从搜索结果中选择你的模型(本示例使用 bge-small-en-v1.5-gguf),并选择要下载的量化版本。由于该模型较小,建议选择 Q8_0,若条件允许也可选择 f16/32。通常,列表越靠下(或数字越大),文件越大,性能越好。

模型下载成功后,你将看到绿色对勾和 “已下载” 字样,下载时间取决于你的网络速度。

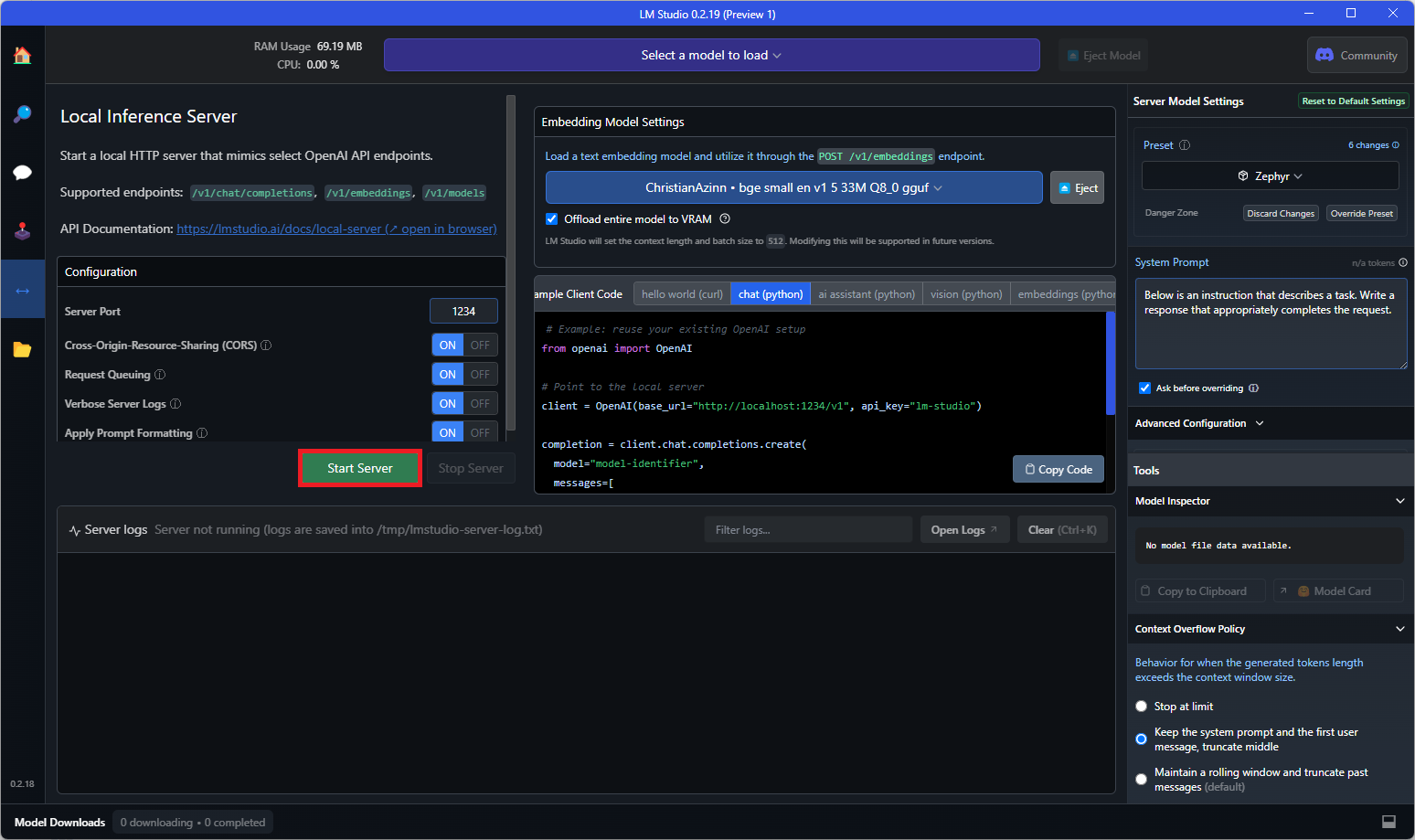

模型下载完成后,点击左侧菜单中的 “本地服务器” 标签,打开文本嵌入模型加载器。该加载器在 0.2.19 版本之前不可用,请确保下载的是正确版本。

从下拉列表中选择刚刚下载的模型进行加载。若模型无法完全加载到显存中,你可能需要在右侧菜单中调整配置,如 GPU 卸载。

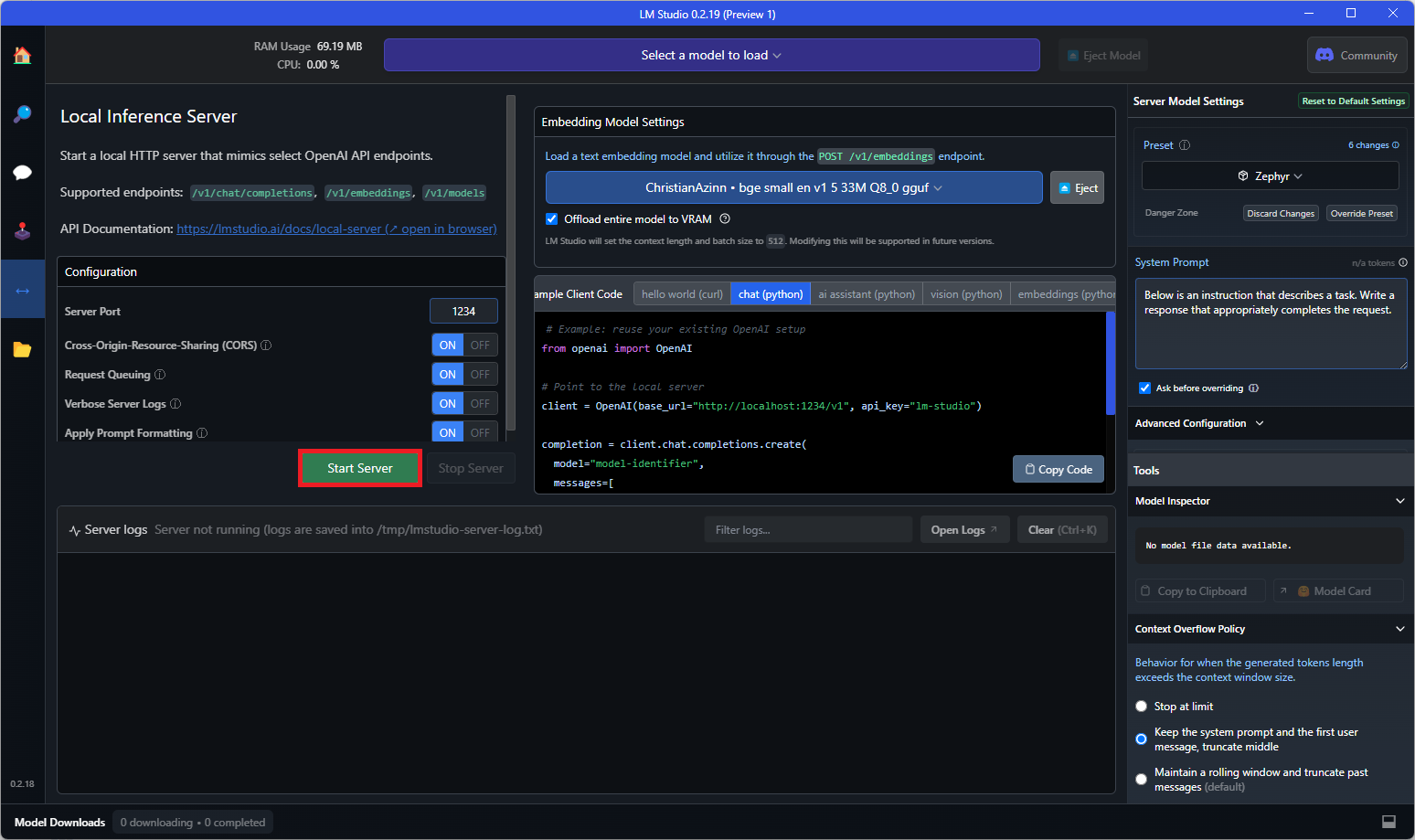

最后,点击 “启动服务器” 按钮:

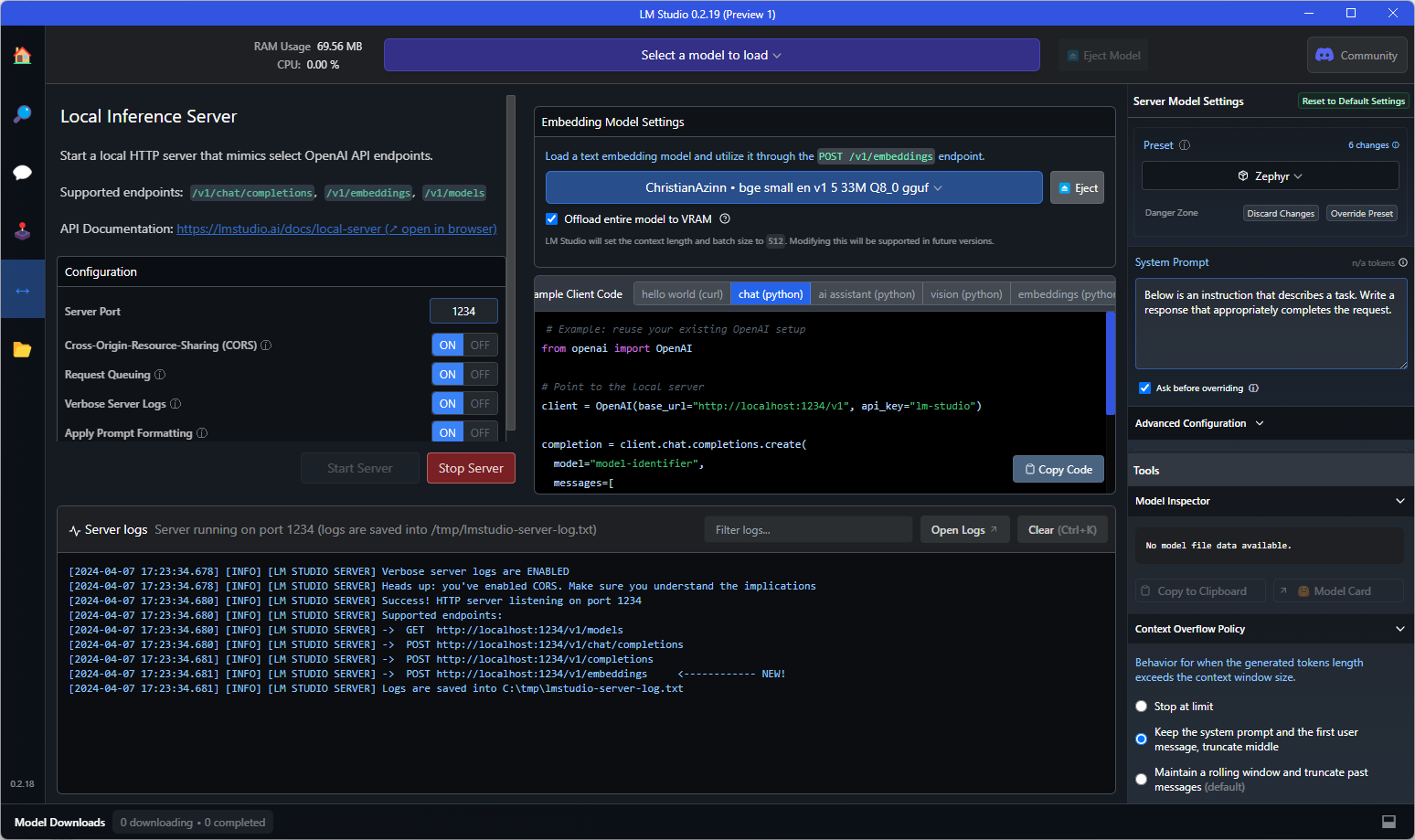

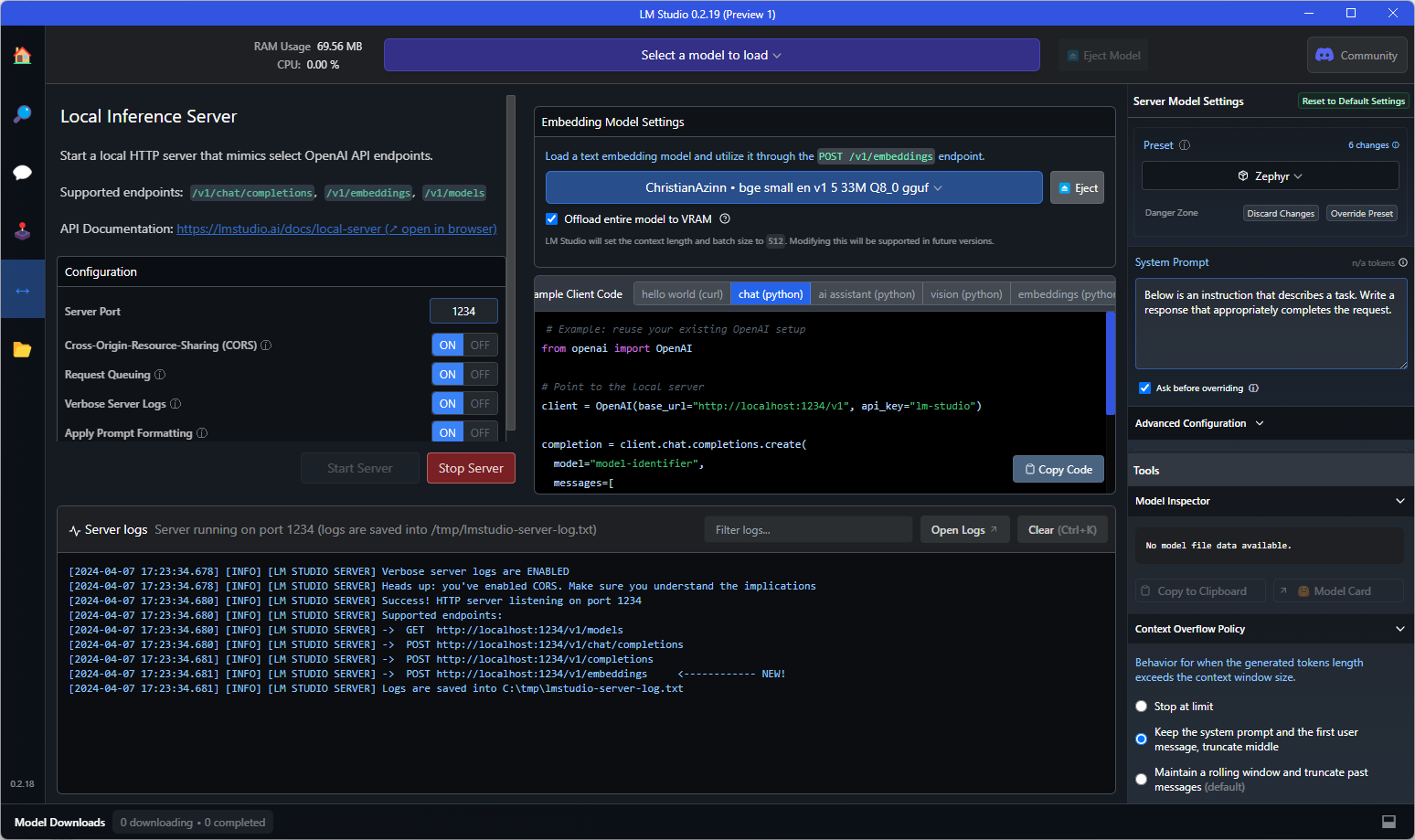

若在控制台看到如下文本,则表示一切就绪!你可以在任何需要的应用程序中直接替换 OpenAI 嵌入 API 使用该模型,也可以直接查询端点进行测试。

以下是一个向 API 端点发送的示例 curl 请求:

curl http://localhost:1234/v1/embeddings \

-H "Content-Type: application/json" \

-d '{

"input": "Your text string goes here",

"model": "model-identifier-here"

}'

更多信息请参考 LM Studio 文本嵌入文档。

✨ 主要特性

📚 详细文档

原始模型描述

这是我们的基础句子嵌入模型,它使用 AnglE 损失函数在高质量大规模数据上进行训练,在 BERT 大规模模型上取得了 SOTA 性能。更多信息请查看我们的 博客文章。

本仓库描述

本仓库包含 mxbai-embed-large-v1 嵌入模型的 GGUF 格式文件。

这些文件是使用 llama.cpp PR 5500,提交记录为 34aa045de,在消费级 RTX 4090 上进行转换和量化的。

该模型支持最多 512 个令牌的上下文。

兼容性

这些文件与截至提交记录 4524290e8 的 llama.cpp 兼容,也与版本 0.2.19 的 LM Studio 兼容。

量化方法说明

点击查看详情

可用的量化方法如下:

* GGML_TYPE_Q2_K - “类型 1” 2 位量化,超级块包含 16 个块,每个块有 16 个权重。块的缩放因子和最小值使用 4 位量化,最终每个权重有效使用 2.5625 位(bpw)。

* GGML_TYPE_Q3_K - “类型 0” 3 位量化,超级块包含 16 个块,每个块有 16 个权重。缩放因子使用 6 位量化,最终每个权重使用 3.4375 位。

* GGML_TYPE_Q4_K - “类型 1” 4 位量化,超级块包含 8 个块,每个块有 32 个权重。缩放因子和最小值使用 6 位量化,最终每个权重使用 4.5 位。

* GGML_TYPE_Q5_K - “类型 1” 5 位量化,与 GGML_TYPE_Q4_K 具有相同的超级块结构,最终每个权重使用 5.5 位。

* GGML_TYPE_Q6_K - “类型 0” 6 位量化,超级块有 16 个块,每个块有 16 个权重。缩放因子使用 8 位量化,最终每个权重使用 6.5625 位。

请参考下面的 “提供的文件” 表格,了解哪些文件使用了哪些方法以及如何使用。

提供的文件

📄 许可证

本模型采用 Apache-2.0 许可证。

致谢

感谢 LM Studio 团队以及所有从事开源 AI 工作的人员。

本 README 受 nomic-ai-embed-text-v1.5-GGUF(另一个优秀的嵌入模型)和传奇的 TheBloke 的 README 启发。

模型元信息

| 属性 |

详情 |

| 模型类型 |

BERT |

| 模型创建者 |

MixedBread AI |

| 量化者 |

ChristianAzinn |

| 库名称 |

sentence-transformers |

| 任务标签 |

特征提取 |

| 标签 |

mteb、transformers、transformers.js、gguf |

| 基础模型 |

mixedbread-ai/mxbai-embed-large-v1 |

| 推理 |

否 |

| 语言 |

英语 |

| 许可证 |

Apache-2.0 |

| 模型名称 |

mxbai-embed-large-v1 |

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语