🚀 Whisper-Large-V3-French-Distil-Dec16

Whisper-Large-V3-French-Distil是Whisper-Large-V3-French的一系列蒸馏版本。通过将解码器层数从32层减少到16层、8层、4层或2层,并使用大规模数据集进行蒸馏,具体可参考这篇论文。

这些蒸馏变体在保持性能(基于保留的层数)的同时,减少了内存使用和推理时间,并降低了幻觉风险,特别是在长文本转录中。此外,它们可以与原始的Whisper-Large-V3-French模型无缝结合进行推测解码,与单独使用该模型相比,可提高推理速度并保证输出的一致性。

该模型已转换为多种格式,便于在不同的库中使用,包括transformers、openai-whisper、fasterwhisper、whisper.cpp、candle、mlx等。

🚀 快速开始

本模型可用于法语语音识别任务,能在多种库中使用,下面将详细介绍其使用方法。

✨ 主要特性

- 蒸馏优化:减少解码器层数,降低内存使用和推理时间,同时保持性能。

- 减少幻觉:降低长文本转录中的幻觉风险。

- 推测解码:可与原始模型结合,提高推理速度。

- 多格式支持:支持多种库,方便在不同环境中使用。

📦 安装指南

根据不同的使用场景,需要安装不同的依赖库,以下是一些常见的安装命令:

OpenAI Whisper

pip install -U openai-whisper

Faster Whisper

pip install faster-whisper

Whisper.cpp

git clone https://github.com/ggerganov/whisper.cpp.git

cd whisper.cpp

make

💻 使用示例

基础用法

Hugging Face Pipeline

import torch

from datasets import load_dataset

from transformers import AutoModelForSpeechSeq2Seq, AutoProcessor, pipeline

device = "cuda:0" if torch.cuda.is_available() else "cpu"

torch_dtype = torch.float16 if torch.cuda.is_available() else torch.float32

model_name_or_path = "bofenghuang/whisper-large-v3-french-distil-dec16"

processor = AutoProcessor.from_pretrained(model_name_or_path)

model = AutoModelForSpeechSeq2Seq.from_pretrained(

model_name_or_path,

torch_dtype=torch_dtype,

low_cpu_mem_usage=True,

)

model.to(device)

pipe = pipeline(

"automatic-speech-recognition",

model=model,

feature_extractor=processor.feature_extractor,

tokenizer=processor.tokenizer,

torch_dtype=torch_dtype,

device=device,

max_new_tokens=128,

)

dataset = load_dataset("bofenghuang/asr-dummy", "fr", split="test")

sample = dataset[0]["audio"]

result = pipe(sample)

print(result["text"])

高级用法

推测解码

import torch

from datasets import load_dataset

from transformers import (

AutoModelForCausalLM,

AutoModelForSpeechSeq2Seq,

AutoProcessor,

pipeline,

)

device = "cuda:0" if torch.cuda.is_available() else "cpu"

torch_dtype = torch.float16 if torch.cuda.is_available() else torch.float32

model_name_or_path = "bofenghuang/whisper-large-v3-french"

processor = AutoProcessor.from_pretrained(model_name_or_path)

model = AutoModelForSpeechSeq2Seq.from_pretrained(

model_name_or_path,

torch_dtype=torch_dtype,

low_cpu_mem_usage=True,

)

model.to(device)

assistant_model_name_or_path = "bofenghuang/whisper-large-v3-french-distil-dec2"

assistant_model = AutoModelForCausalLM.from_pretrained(

assistant_model_name_or_path,

torch_dtype=torch_dtype,

low_cpu_mem_usage=True,

)

assistant_model.to(device)

pipe = pipeline(

"automatic-speech-recognition",

model=model,

feature_extractor=processor.feature_extractor,

tokenizer=processor.tokenizer,

torch_dtype=torch_dtype,

device=device,

generate_kwargs={"assistant_model": assistant_model},

max_new_tokens=128,

)

dataset = load_dataset("bofenghuang/asr-dummy", "fr", split="test")

sample = dataset[0]["audio"]

result = pipe(sample)

print(result["text"])

📚 详细文档

性能评估

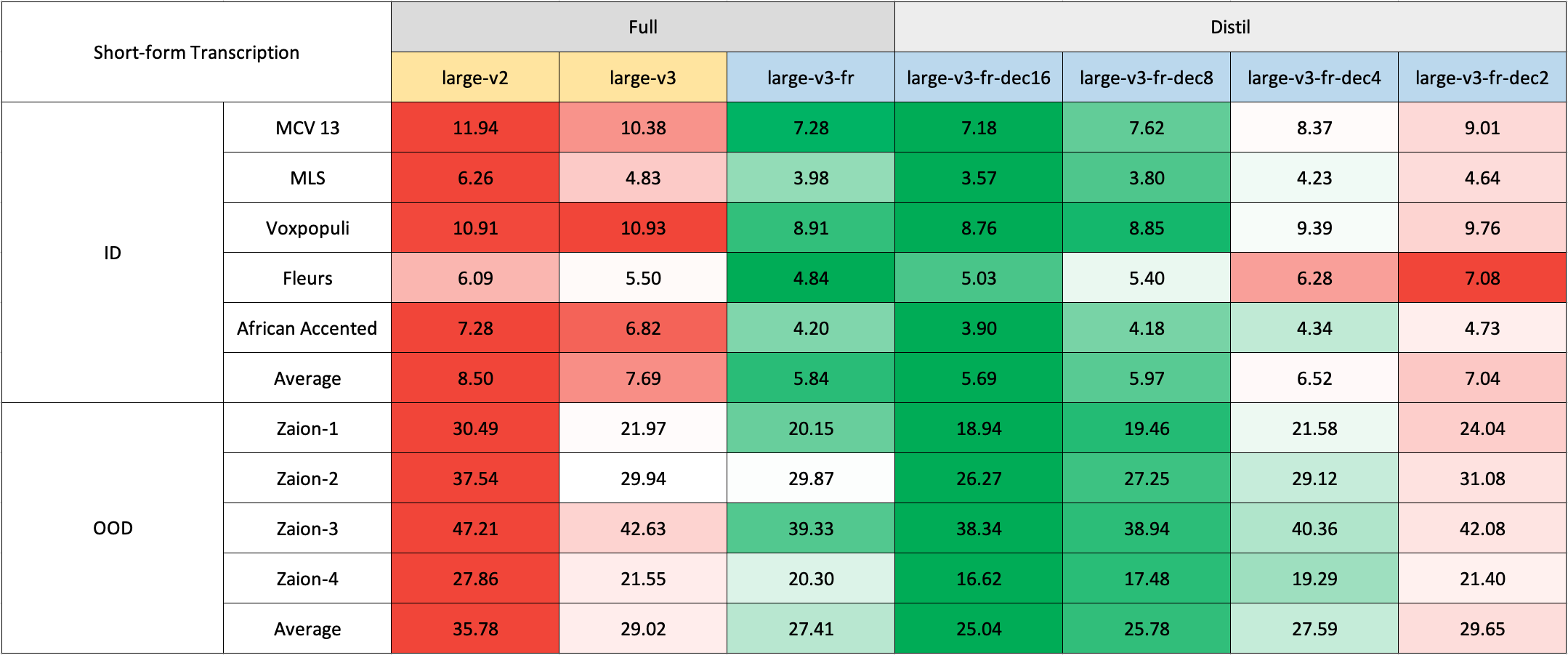

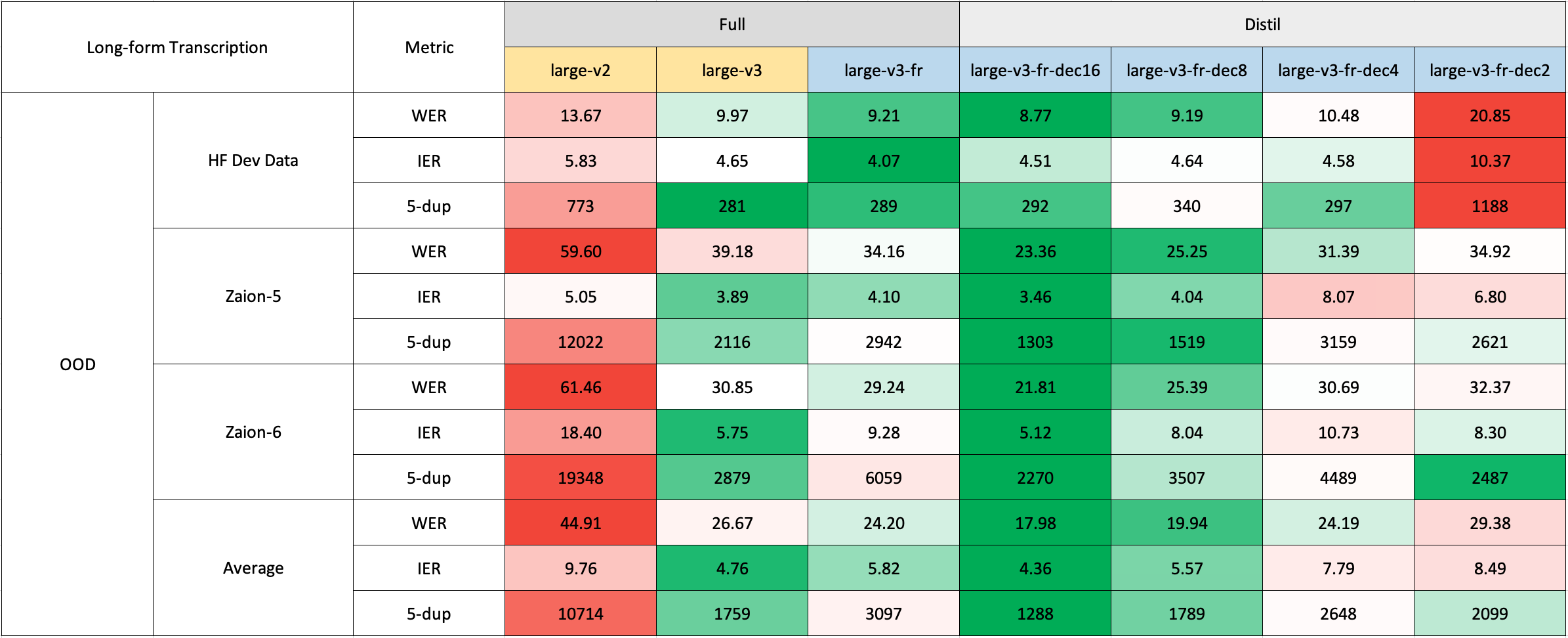

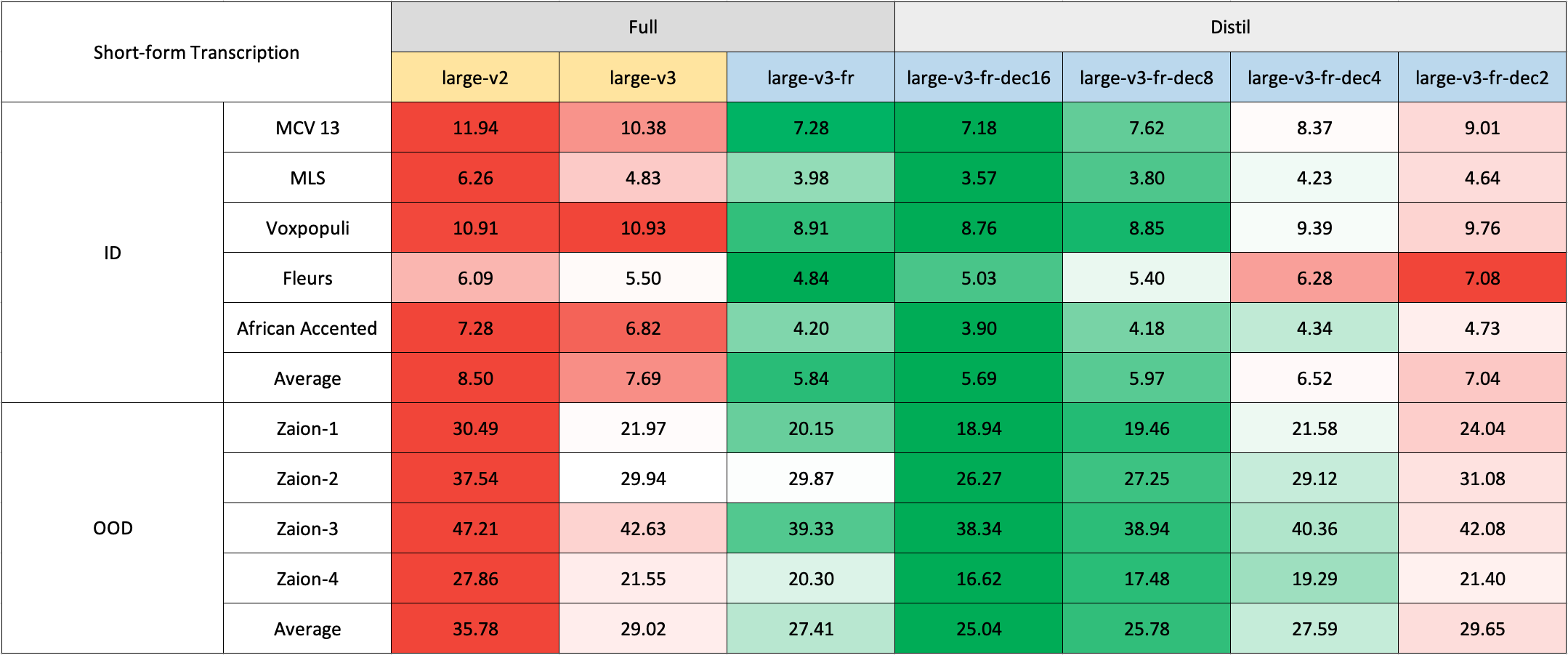

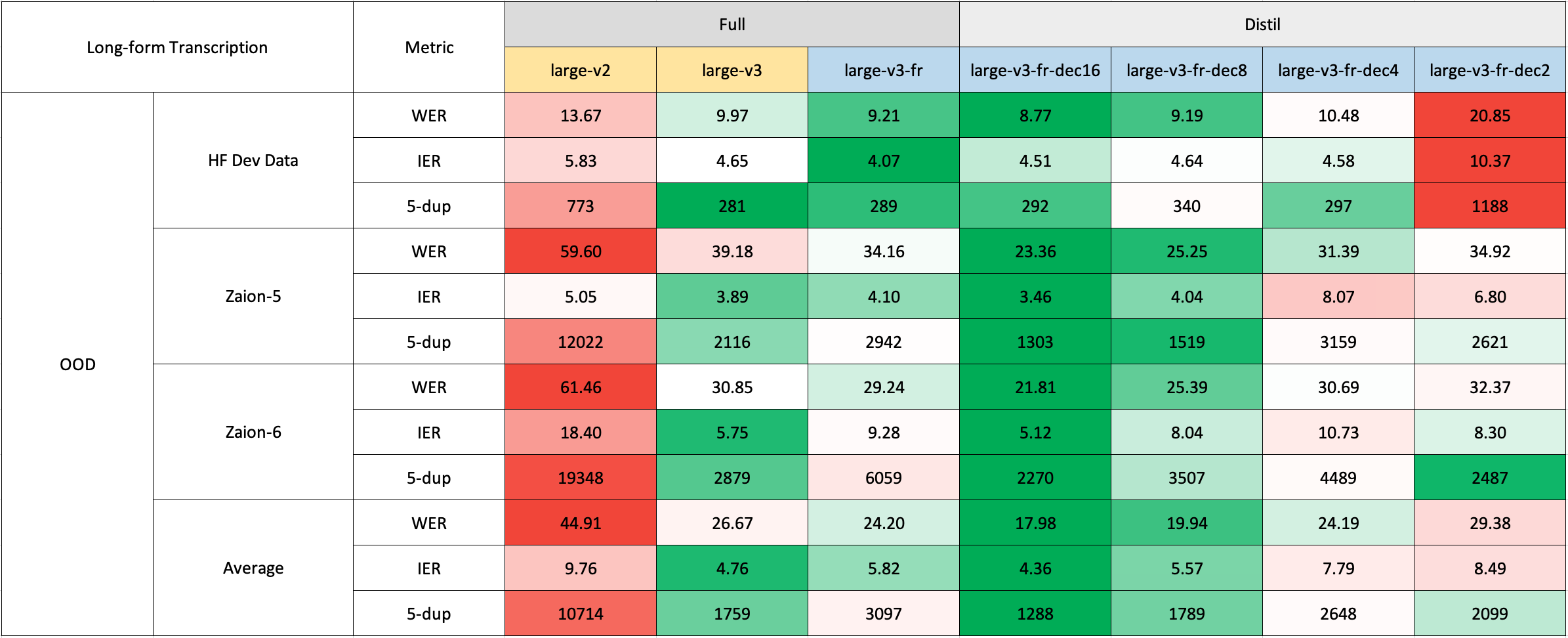

我们在短文本和长文本转录上对模型进行了评估,并在分布内和分布外数据集上进行了测试,以全面分析其准确性、泛化性和鲁棒性。

请注意,报告的WER是在将数字转换为文本、去除标点符号(除了撇号和连字符)并将所有字符转换为小写后的结果。

所有公共数据集的评估结果可在此处找到。

短文本转录

由于缺乏现成的法语域外(OOD)和长文本测试集,我们使用了Zaion Lab的内部测试集进行评估。这些测试集包含来自呼叫中心对话的人工标注音频转录对,其特点是背景噪音大且包含特定领域的术语。

长文本转录

长文本转录使用🤗 Hugging Face管道进行,以加快评估速度。音频文件被分割成30秒的片段并并行处理。

训练细节

我们收集了一个包含超过2500小时法语语音识别数据的复合数据集,其中包括Common Voice 13.0、Multilingual LibriSpeech、Voxpopuli、Fleurs、Multilingual TEDx、MediaSpeech、African Accented French等数据集。

由于一些数据集(如MLS)只提供没有大小写和标点的文本,我们使用了🤗 Speechbox的定制版本,使用bofenghuang/whisper-large-v2-cv11-french模型从有限的符号集中恢复大小写和标点。

然而,即使在这些数据集中,我们也观察到了一些质量问题。这些问题包括音频和转录在语言或内容上的不匹配、分割不佳的话语、脚本语音中缺失的单词等。我们建立了一个管道来过滤掉许多这些有问题的话语,以提高数据集的质量。因此,我们排除了超过10%的数据,并且在重新训练模型时,我们注意到幻觉现象显著减少。

在训练方面,我们使用了🤗 Distil-Whisper仓库中的脚本。模型训练在GENCI的Jean-Zay超级计算机上进行,我们感谢IDRIS团队在整个项目中提供的及时支持。

🔧 技术细节

本模型是基于Whisper-Large-V3-French进行蒸馏得到的,通过减少解码器层数和使用大规模数据集进行蒸馏,提高了模型的效率和性能。在推理过程中,可使用推测解码技术,结合草稿模型和主模型,提高推理速度。

📄 许可证

本项目采用MIT许可证。

致谢

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语