模型简介

模型特点

模型能力

使用案例

🚀 ColPali:基于PaliGemma - 3B和ColBERT策略的视觉检索器

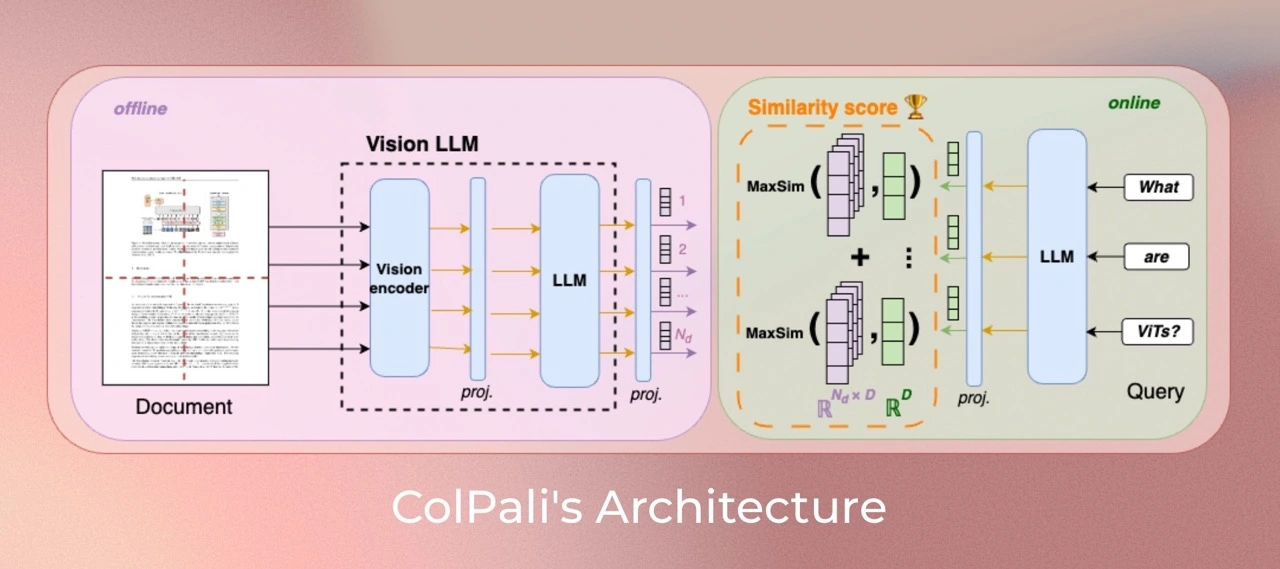

ColPali是一个基于视觉语言模型(VLMs)的新型模型架构和训练策略的模型,可根据文档的视觉特征对其进行高效索引。它是PaliGemma - 3B的扩展,能够生成ColBERT风格的文本和图像多向量表示。该模型在论文ColPali: Efficient Document Retrieval with Vision Language Models中被提出,并首次在此仓库中发布。

✨ 主要特性

- 基于新颖的模型架构和训练策略,能从视觉特征高效索引文档。

- 作为PaliGemma - 3B的扩展,可生成ColBERT风格的多向量表示。

📦 安装指南

文档未提供具体安装步骤,故跳过此章节。

💻 使用示例

基础用法

import torch

import typer

from torch.utils.data import DataLoader

from tqdm import tqdm

from transformers import AutoProcessor

from PIL import Image

from colpali_engine.models.paligemma_colbert_architecture import ColPali

from colpali_engine.trainer.retrieval_evaluator import CustomEvaluator

from colpali_engine.utils.colpali_processing_utils import process_images, process_queries

from colpali_engine.utils.image_from_page_utils import load_from_dataset

def main() -> None:

"""Example script to run inference with ColPali"""

# Load model

model_name = "vidore/colpali-v1.1"

model = ColPali.from_pretrained("vidore/colpaligemma-3b-mix-448-base", torch_dtype=torch.bfloat16, device_map="cuda").eval()

model.load_adapter(model_name)

model = model.eval()

processor = AutoProcessor.from_pretrained(model_name)

# select images -> load_from_pdf(<pdf_path>), load_from_image_urls(["<url_1>"]), load_from_dataset(<path>)

images = load_from_dataset("vidore/docvqa_test_subsampled")

queries = ["From which university does James V. Fiorca come ?", "Who is the japanese prime minister?"]

# run inference - docs

dataloader = DataLoader(

images,

batch_size=4,

shuffle=False,

collate_fn=lambda x: process_images(processor, x),

)

ds = []

for batch_doc in tqdm(dataloader):

with torch.no_grad():

batch_doc = {k: v.to(model.device) for k, v in batch_doc.items()}

embeddings_doc = model(**batch_doc)

ds.extend(list(torch.unbind(embeddings_doc.to("cpu"))))

# run inference - queries

dataloader = DataLoader(

queries,

batch_size=4,

shuffle=False,

collate_fn=lambda x: process_queries(processor, x, Image.new("RGB", (448, 448), (255, 255, 255))),

)

qs = []

for batch_query in dataloader:

with torch.no_grad():

batch_query = {k: v.to(model.device) for k, v in batch_query.items()}

embeddings_query = model(**batch_query)

qs.extend(list(torch.unbind(embeddings_query.to("cpu"))))

# run evaluation

retriever_evaluator = CustomEvaluator(is_multi_vector=True)

scores = retriever_evaluator.evaluate(qs, ds)

print(scores.argmax(axis=1))

if __name__ == "__main__":

typer.run(main)

高级用法

# 若需要从该适配器进一步训练ColPali,应运行以下代码

lora_config = LoraConfig.from_pretrained("vidore/colpali-v1.1")

lora_config.inference_mode = False # force training mode for fine-tuning

model = get_peft_model(model, lora_config)

print("after")

model.print_trainable_parameters()

📚 详细文档

版本特性

此版本使用colpali - engine==0.2.0进行训练。与colpali相比,该版本在查询编码时使用右填充进行训练,以修复查询编码中不需要的标记。它还基于修复后的vidore/colpaligemma - 3b - mix - 448 - base,以保证投影层初始化的确定性。数据与论文中描述的ColPali数据相同。

模型描述

该模型从现成的SigLIP模型开始迭代构建。我们对其进行微调以创建BiSigLIP,并将SigLIP输出的图像块嵌入输入到大型语言模型PaliGemma - 3B中,以创建BiPali。

通过语言模型输入图像块嵌入的一个好处是,它们可以自然地映射到与文本输入(查询)相似的潜在空间。这使得可以利用ColBERT策略来计算文本标记和图像块之间的交互,与BiPali相比,性能有了显著提升。

模型训练

数据集

我们的训练数据集包含127,460个查询 - 页面对,由公开可用的学术数据集的训练集(63%)和一个合成数据集组成,合成数据集由网络爬取的PDF文档页面组成,并使用VLM生成的(Claude - 3 Sonnet)伪问题进行扩充(37%)。我们的训练集在设计上完全是英文的,这使我们能够研究对非英语语言的零样本泛化能力。我们明确验证了没有多页PDF文档同时用于ViDoRe和训练集中,以防止评估污染。使用2%的样本创建了一个验证集,用于调整超参数。

注意:多语言数据存在于语言模型(Gemma - 2B)的预训练语料库中,并且可能在PaliGemma - 3B的多模态训练期间出现。

参数

所有模型在训练集上训练1个epoch。除非另有说明,我们以bfloat16格式训练模型,在语言模型的Transformer层以及最终随机初始化的投影层上使用低秩适配器(LoRA),其中alpha = 32和r = 32,并使用paged_adamw_8bit优化器。我们在8个GPU的设置上进行数据并行训练,学习率为5e - 5,采用线性衰减,热身步骤为2.5%,批量大小为32。

局限性

- 适用范围:该模型主要专注于PDF类型的文档和资源丰富的语言,可能限制其对其他文档类型或代表性不足语言的泛化能力。

- 适配难度:该模型依赖于从ColBERT后期交互机制派生的多向量检索,可能需要进行工程努力才能适应缺乏原生多向量支持的广泛使用的向量检索框架。

信息表格

| 属性 | 详情 |

|---|---|

| 模型类型 | 基于视觉语言模型(VLMs)的视觉文档检索模型 |

| 训练数据 | 由公开学术数据集训练集(63%)和合成数据集(37%)组成,合成数据集包含网络爬取的PDF文档页面和VLM生成的伪问题 |

联系信息

- Manuel Faysse:manuel.faysse@illuin.tech

- Hugues Sibille:hugues.sibille@illuin.tech

- Tony Wu:tony.wu@illuin.tech

🔧 技术细节

文档未提供更详细的技术实现细节,故跳过此章节。

📄 许可证

ColPali的视觉语言主干模型(PaliGemma)根据其模型卡片中的规定,遵循gemma许可证。附加到模型上的适配器遵循MIT许可证。

引用

如果您在研究中使用了该组织的任何数据集或模型,请按以下方式引用原始数据集:

@misc{faysse2024colpaliefficientdocumentretrieval,

title={ColPali: Efficient Document Retrieval with Vision Language Models},

author={Manuel Faysse and Hugues Sibille and Tony Wu and Bilel Omrani and Gautier Viaud and Céline Hudelot and Pierre Colombo},

year={2024},

eprint={2407.01449},

archivePrefix={arXiv},

primaryClass={cs.IR},

url={https://arxiv.org/abs/2407.01449},

}

Transformers

Transformers Transformers 英语

Transformers 英语 Transformers

Transformers Transformers

Transformers Transformers

Transformers Transformers

Transformers Transformers 支持多种语言

Transformers 支持多种语言 Transformers

Transformers Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语