🚀 MatCha - 基础模型卡片

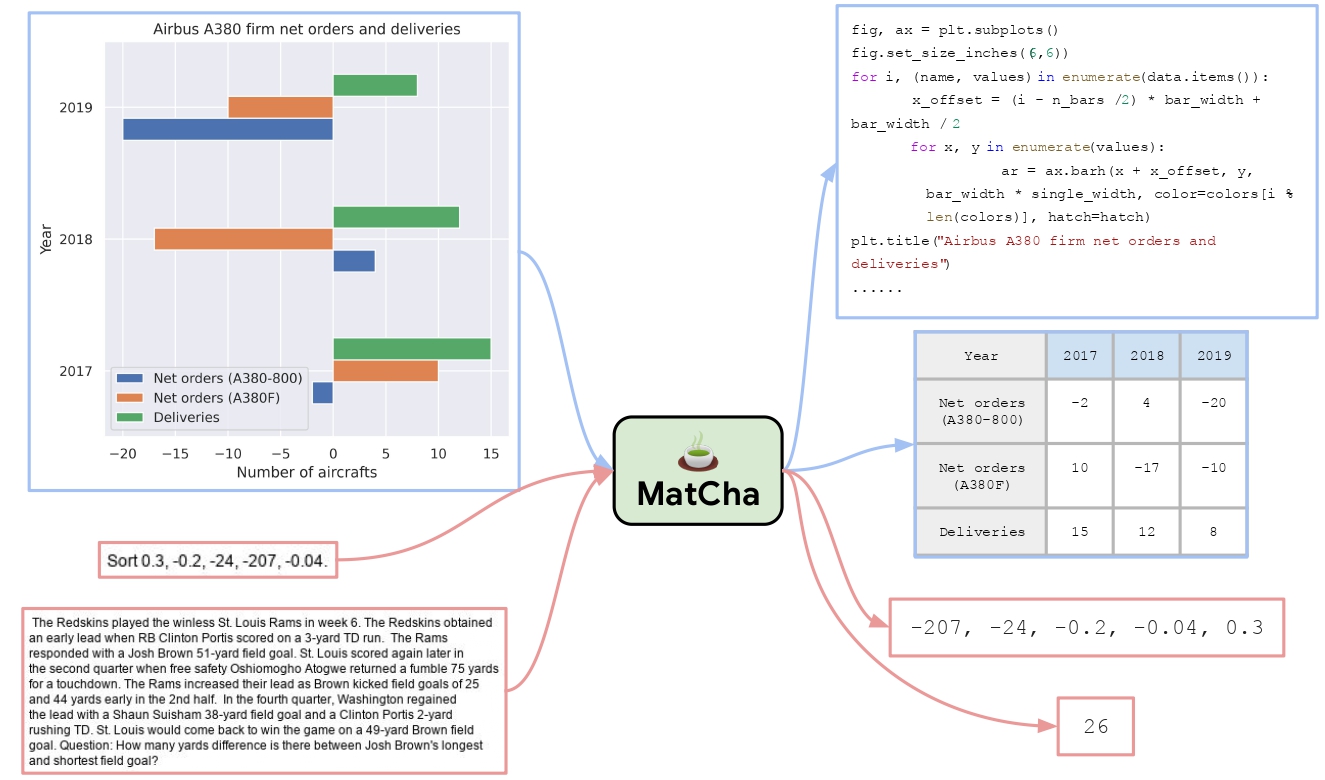

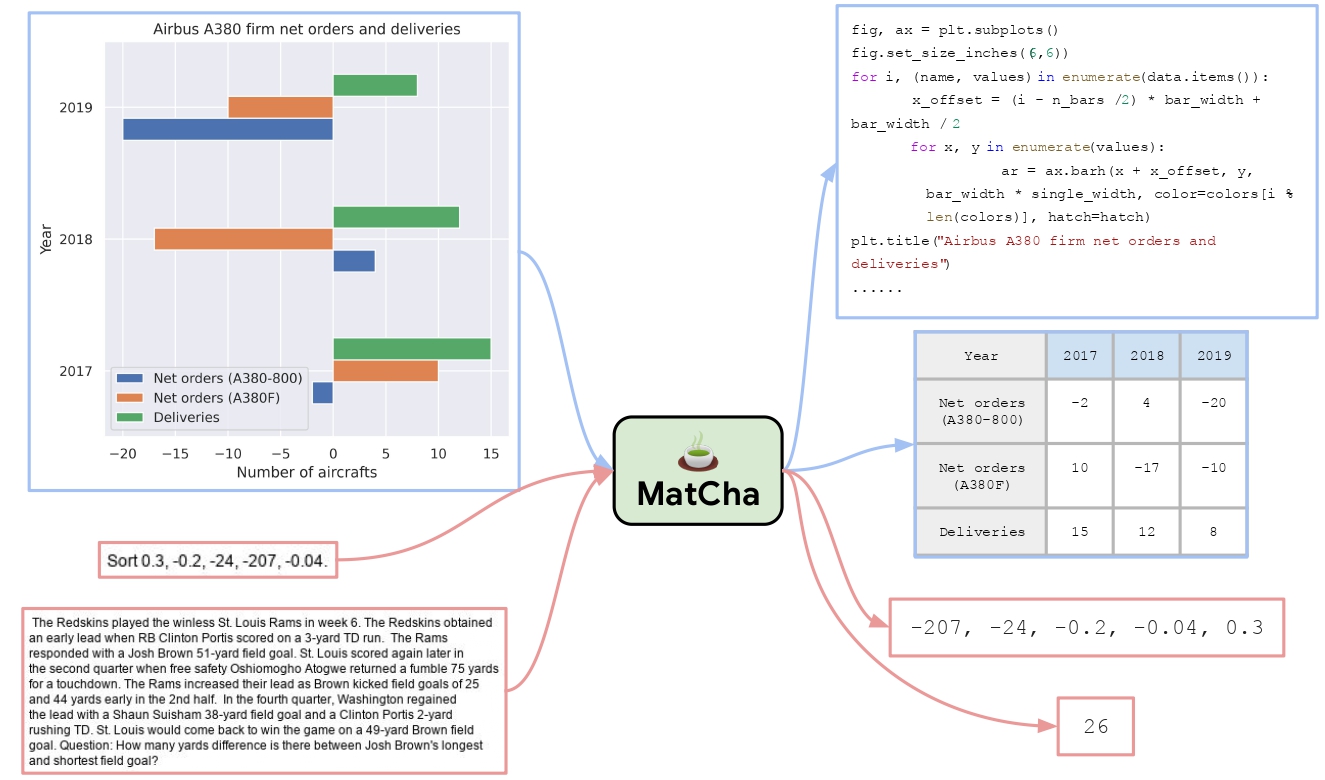

MatCha基础模型可用于视觉问答任务,能有效处理图表、图像等视觉语言数据,提升视觉语言模型对图表和语言数据的联合建模能力。

🚀 快速开始

本模型是MatCha基础模型,仅可用于微调。

📚 详细文档

内容目录

- 简要概述

- 模型使用

- 贡献者

- 引用信息

简要概述

论文摘要指出:

视觉语言数据(如图表、绘图和信息图)在人类世界中无处不在。然而,现有的最先进的视觉语言模型在处理这些数据时表现不佳。我们提出了MATCHA(数学推理和图表反渲染预训练),以增强视觉语言模型对图表/绘图和语言数据进行联合建模的能力。具体来说,我们提出了几个预训练任务,涵盖了绘图解构和数值推理,这些都是视觉语言建模中的关键能力。我们从最近提出的图像到文本视觉语言模型Pix2Struct开始进行MATCHA预训练。在PlotQA和ChartQA等标准基准测试中,MATCHA模型的表现比现有最先进的方法高出近20%。我们还研究了MATCHA预训练在截图、教科书图表和文档图形等领域的迁移效果,并观察到整体性能有所提升,这验证了MATCHA预训练在更广泛的视觉语言任务中的实用性。

模型使用

基础用法

from transformers import Pix2StructProcessor, Pix2StructForConditionalGeneration

import requests

from PIL import Image

processor = Pix2StructProcessor.from_pretrained('google/matcha-base')

model = Pix2StructForConditionalGeneration.from_pretrained('google/matcha-base')

url = "https://raw.githubusercontent.com/vis-nlp/ChartQA/main/ChartQA%20Dataset/val/png/20294671002019.png"

image = Image.open(requests.get(url, stream=True).raw)

inputs = processor(images=image, text="Is the sum of all 4 places greater than Laos?", return_tensors="pt")

predictions = model.generate(**inputs, max_new_tokens=512)

print(processor.decode(predictions[0], skip_special_tokens=True))

>>> No

从T5x转换到Hugging Face

你可以使用convert_pix2struct_checkpoint_to_pytorch.py脚本进行转换:

python convert_pix2struct_checkpoint_to_pytorch.py --t5x_checkpoint_path PATH_TO_T5X_CHECKPOINTS --pytorch_dump_path PATH_TO_SAVE --is_vqa

如果你要转换一个大模型,请运行:

python convert_pix2struct_checkpoint_to_pytorch.py --t5x_checkpoint_path PATH_TO_T5X_CHECKPOINTS --pytorch_dump_path PATH_TO_SAVE --use-large --is_vqa

保存后,你可以使用以下代码将转换后的模型推送到Hugging Face Hub:

from transformers import Pix2StructForConditionalGeneration, Pix2StructProcessor

model = Pix2StructForConditionalGeneration.from_pretrained(PATH_TO_SAVE)

processor = Pix2StructProcessor.from_pretrained(PATH_TO_SAVE)

model.push_to_hub("USERNAME/MODEL_NAME")

processor.push_to_hub("USERNAME/MODEL_NAME")

贡献者

该模型最初由Fangyu Liu、Francesco Piccinno等人贡献,并由Younes Belkada添加到Hugging Face生态系统中。

引用信息

如果你想引用这项工作,请考虑引用原始论文:

@misc{liu2022matcha,

title={MatCha: Enhancing Visual Language Pretraining with Math Reasoning and Chart Derendering},

author={Fangyu Liu and Francesco Piccinno and Syrine Krichene and Chenxi Pang and Kenton Lee and Mandar Joshi and Yasemin Altun and Nigel Collier and Julian Martin Eisenschlos},

year={2022},

eprint={2212.09662},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

模型信息

| 属性 |

详情 |

| 支持语言 |

英语、法语、罗马尼亚语、德语、多语言 |

| 推理功能 |

不支持 |

| 任务类型 |

视觉问答 |

| 许可证 |

Apache 2.0 |

| 标签 |

matcha |

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语