🚀 时尚前沿大语言模型(Trendyol LLM)

时尚前沿大语言模型(Trendyol LLM)是一款基于LLaMa2 7B模型的生成式模型。此仓库为基础模型仓库,它能够助力文本生成相关的各类应用,为自然语言处理任务提供强大支持。

📚 详细文档

模型详情

| 属性 |

详情 |

| 模型开发者 |

Trendyol |

| 模型变体 |

基础版和对话版 |

| 输入 |

模型仅接受文本输入 |

| 输出 |

模型仅生成文本输出 |

| 模型架构 |

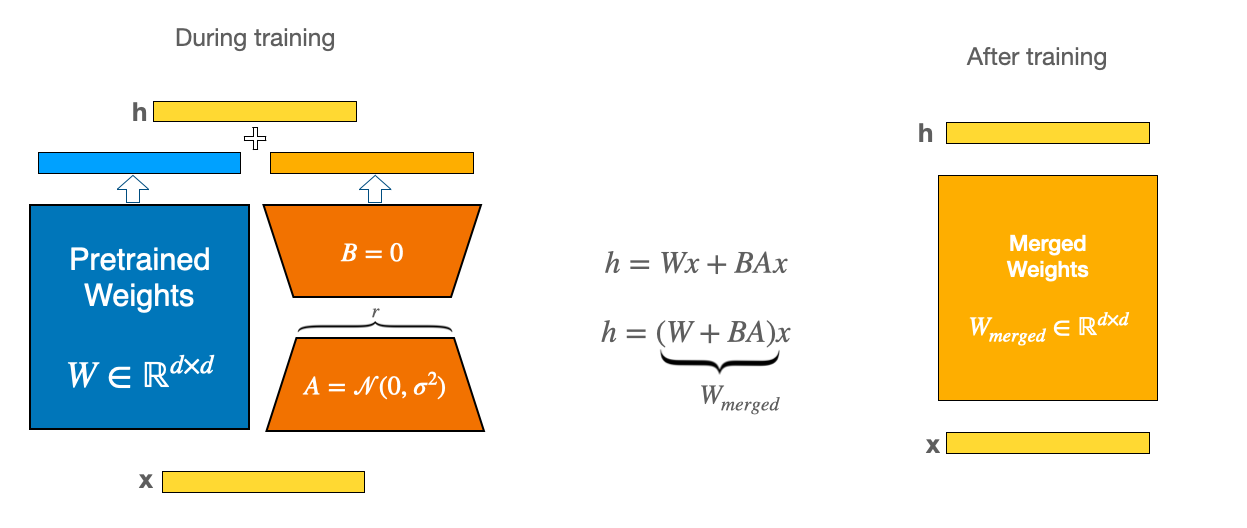

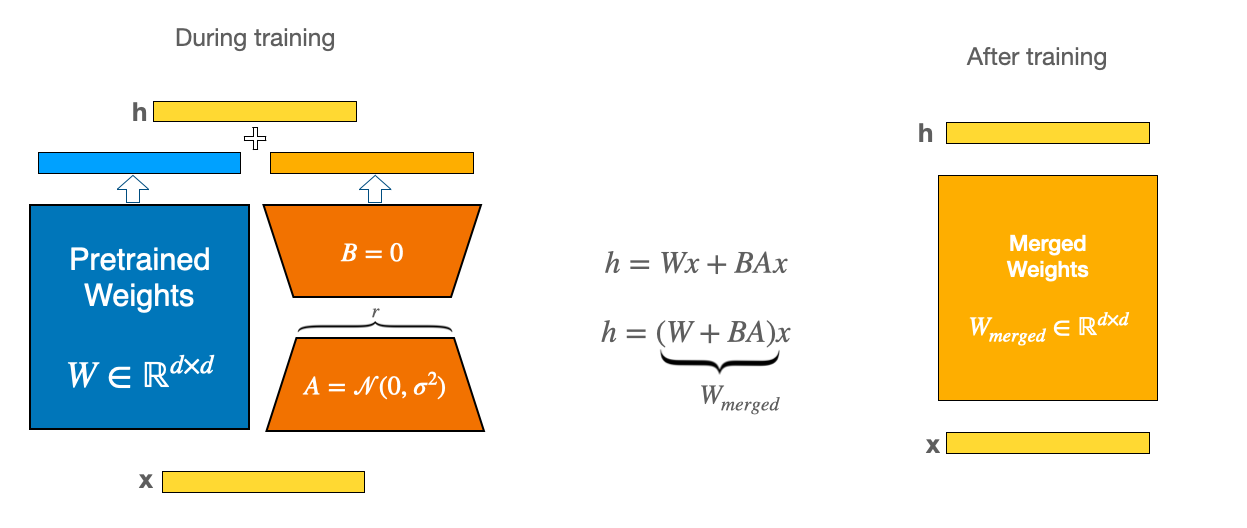

时尚前沿大语言模型(Trendyol LLM)是一个自回归语言模型(基于LLaMa2 7B),采用了优化的Transformer架构。基础版本在100亿个标记上进行了微调,使用LoRA进行训练,参数如下:

- lr=2e - 4

- lora_rank=64

- lora_alpha=128

- lora_trainable=q_proj,v_proj,k_proj,o_proj,gate_proj,down_proj,up_proj

- modules_to_save=embed_tokens,lm_head

- lora_dropout=0.05

- fp16=True

- max_seq_length=1024 |

使用示例

基础用法

from transformers import AutoModelForCausalLM, LlamaTokenizer, pipeline

model_id = "Trendyol/Trendyol-LLM-7b-base-v0.1"

tokenizer = LlamaTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(model_id,

device_map='auto',

load_in_8bit=True)

sampling_params = dict(do_sample=True, temperature=0.3, top_k=50, top_p=0.9)

pipe = pipeline("text-generation",

model=model,

tokenizer=tokenizer,

device_map="auto",

max_new_tokens=1024,

return_full_text=True,

repetition_penalty=1.1

)

def generate_output(user_query):

outputs = pipe(user_query,

**sampling_params

)

return outputs[0]["generated_text"]

user_query = "Ders çalışmanın en iyi 5 yolu:"

response = generate_output(user_query)

局限性、风险、偏差和伦理考量

局限性和已知偏差

- 主要功能和应用:时尚前沿大语言模型(Trendyol LLM)是一个自回归语言模型,主要用于预测文本字符串中的下一个标记。虽然它常用于各种应用,但需要注意的是,它尚未经过广泛的实际应用测试。其在不同场景下的有效性和可靠性在很大程度上尚未得到验证。

- 语言理解和生成:该模型主要在标准英语和土耳其语上进行训练。它在理解和生成俚语、非正式语言或其他语言方面的性能可能有限,可能导致潜在的错误或误解。

- 虚假信息生成:用户应该意识到,时尚前沿大语言模型(Trendyol LLM)可能会产生不准确或误导性的信息。输出结果应被视为起点或建议,而不是确定的答案。

风险和伦理考量

- 有害使用的可能性:时尚前沿大语言模型(Trendyol LLM)有可能被用于生成冒犯性或有害的语言。我们强烈反对将其用于任何此类目的,并强调在部署前需要进行特定应用的安全性和公平性评估。

- 意外内容和偏差:该模型在大量文本数据上进行训练,这些数据没有明确检查是否存在冒犯性内容或现有偏差。因此,它可能会无意中产生反映这些偏差或不准确之处的内容。

- 毒性:尽管努力选择合适的训练数据,但该模型仍有可能生成有害内容,尤其是在明确提示的情况下。我们鼓励开源社区参与制定策略,以尽量减少此类风险。

安全和道德使用建议

- 人工监督:我们建议引入人工审核层或使用过滤器来管理和提高输出质量,特别是在面向公众的应用中。这种方法可以帮助降低意外生成令人反感内容的风险。

- 特定应用测试:打算使用时尚前沿大语言模型(Trendyol LLM)的开发者应该针对其特定应用进行全面的安全测试和优化。这一点至关重要,因为模型的响应可能不可预测,偶尔可能存在偏差、不准确或冒犯性。

- 负责任的开发和部署:时尚前沿大语言模型(Trendyol LLM)的开发者和用户有责任确保其符合道德和安全应用。我们敦促用户注意模型的局限性,并采取适当的保障措施,以防止滥用或产生有害后果。

📄 许可证

本项目采用Apache - 2.0许可证。

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语