模型简介

模型特点

模型能力

使用案例

🚀 ToRoLaMa:越南语指令跟随与聊天模型

ToRoLaMa 是越南的 Taureau AI 与法国的 Torus AI 合作的成果。它是一个开源的多轮大型语言模型(LLM),最初专注于越南语,是迈向支持多种国际语言这一更广泛目标的第一步。

🚀 快速开始

ToRoLaMa 使用了与 Vicuna 类似的提示格式,适用于多轮、高速且高效利用令牌的对话。以下是一个示例提示:

Cuộc hội thoại giữa người dùng và một trí thông minh nhân tạo. Đưa ra câu trả lời chính xác, giúp ích cho người dùng.

USER: chào

ASSISTANT: Xin chào! Tôi có thể giúp gì cho bạn hôm nay?</s>

USER: để quản lý thời gian hiệu quả tôi nên làm thế nào??

ASSISTANT: Để quản lý thời gian hiệu quả, bạn có thể thực hiện các bước sau đây:

Lập kế hoạch: Tạo ra lịch trình hoặc danh sách công việc cần làm trong ngày hoặc tuần.

Ưu tiên công việc: Xác định công việc quan trọng và ưu tiên thực hiện trước.

Sử dụng lịch: Sử dụng lịch để theo dõi các hoạt động và sự kiện trong ngày.

Sử dụng một số công cụ hỗ trợ: Sử dụng các công cụ trực tuyến, ứng dụng điện thoại di động để giúp quản lý thời gian.

Tránh phân tâm: Tránh những việc phức tạp và không cần thiết để giải quyết trong quá trình làm việc.

Nghỉ ngơi: Để giảm căng thẳng và tăng năng suất, hãy dành thời gian nghỉ ngơi giữa các công việc.

Đánh giá và cải tiến: Đánh giá các phương pháp quản lý thời gian của bạn để tìm cách cải tiến trong tương lai.

Những cách trên sẽ giúp bạn quản lý thời gian hiệu quả hơn và tăng cường năng suất trong công việc.</s>

我们的 GitHub 仓库中的 inference_hf.py 文件包含了一个从 Huggingface hub 运行 ToRoLaMa 模型的示例代码。使用以下命令执行:

python inference_hf.py

部署

ToRoLaMa 可以使用 Fastchat 轻松部署。

步骤 1:安装 fastchat

pip3 install "fschat[model_worker,webui]"

步骤 2:运行 RESTful API 服务器

首先运行控制器:

python3 -m fastchat.serve.controller

接下来启动模型工作器:

python3 -m fastchat.serve.model_worker --model-path path-to-ToRoLaMa --conv-template vicuna_v1.1

然后启动 RESTful API 服务器:

python3 -m fastchat.serve.openai_api_server --host localhost --port 8000

最后,运行示例 streamlit 代码:

streamlit run demo.py

✨ 主要特性

- 多语言支持:最初专注于越南语,未来计划扩展到其他语言。

- 高性能:使用多样化和广泛的数据集进行训练,旨在提供增强的语言理解和表示能力,有望达到甚至超越现有商业大语言模型的效率、性能和适用性。

- 开源:以开源形式发布,遵循 LLaMA 2 Community License。

- 快速高效:模型尺寸较小,结合创新的 Vietnamese Tokenizer,令牌长度比 ChatGPT 和 LLaMA 用于越南语短语时短 25%,提升了速度。

- 易于部署:可以使用 Fastchat 轻松部署。

📦 安装指南

安装 fastchat

pip3 install "fschat[model_worker,webui]"

💻 使用示例

基础用法

Cuộc hội thoại giữa người dùng và một trí thông minh nhân tạo. Đưa ra câu trả lời chính xác, giúp ích cho người dùng.

USER: chào

ASSISTANT: Xin chào! Tôi có thể giúp gì cho bạn hôm nay?</s>

高级用法

USER: để quản lý thời gian hiệu quả tôi nên làm thế nào??

ASSISTANT: Để quản lý thời gian hiệu quả, bạn có thể thực hiện các bước sau đây:

Lập kế hoạch: Tạo ra lịch trình hoặc danh sách công việc cần làm trong ngày hoặc tuần.

Ưu tiên công việc: Xác định công việc quan trọng và ưu tiên thực hiện trước.

Sử dụng lịch: Sử dụng lịch để theo dõi các hoạt động và sự kiện trong ngày.

Sử dụng một số công cụ hỗ trợ: Sử dụng các công cụ trực tuyến, ứng dụng điện thoại di động để giúp quản lý thời gian.

Tránh phân tâm: Tránh những việc phức tạp và không cần thiết để giải quyết trong quá trình làm việc.

Nghỉ ngơi: Để giảm căng thẳng và tăng năng suất, hãy dành thời gian nghỉ ngơi giữa các công việc.

Đánh giá và cải tiến: Đánh giá các phương pháp quản lý thời gian của bạn để tìm cách cải tiến trong tương lai.

Những cách trên sẽ giúp bạn quản lý thời gian hiệu quả hơn và tăng cường năng suất trong công việc.</s>

📚 详细文档

模型权重

我们最新的 ToRoLaMa 权重可以在以下位置找到:

| 日期 | 版本 | Huggingface 仓库 | 上下文长度 |

|---|---|---|---|

| 19/12/2023 | ToRoLaMa-7B-1.0 |

ToRoLaMa 7B 1.0 | 2048 |

团队介绍

- Torus AI:于 2019 年在法国图卢兹由一群科学家在 Nguyen Tien Zung 教授的领导下成立。Torus Actions 这个名字来源于 Zung 发现的 the toric conservation principle:

Everything conserved by a dynamical system is also conserved by its associated torus actions.

- Taureau AI:由 Torus AI 的人员于 2021 年在越南河内成立,专注于通用人工智能平台的开发、人工智能产品工程和软件开发,为 Torus AI 生态系统内外的其他公司提供服务。

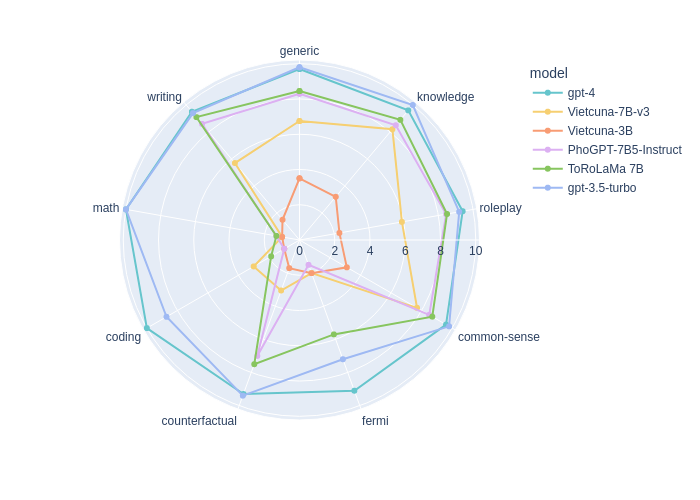

评估

我们使用 Vicuna 和 PhoGPT 的基准测试结果来评估 ToRoLaMa,并使用 Fastchat MT-bench 方法 将我们的结果与其他模型进行比较。

基准测试得分

| 排名 | 模型 | 得分 |

|---|---|---|

| 1 | gpt-4 | 9.52500 |

| 2 | gpt-3.5-turbo | 9.23750 |

| 3 | ToRoLaMa 7B | 7.31875 |

| 4 | URA-LLaMA-13B* | 6.98750 |

| 5 | PhoGPT-7B5-Instruct | 6.49375 |

| 6 | Vietcuna-7B-v3 | 5.21250 |

| 7 | URA-LLaMA-7B* | 3.58750 |

| 8 | Vietcuna-3B | 2.28750 |

*注:URA 模型的得分未考虑它们经常用英语回答越南语问题这一事实。

各主题基准测试详情

上述基准测试结果表明,ToRoLaMa 在定性任务方面优于其他模型,特别是在写作和回答问题方面几乎与 GPT - 3.5 - turbo 相当。然而,由于其训练数据的性质,它在编码和数学等定量任务中存在局限性,这为未来在 STEM 相关任务上的改进提供了机会。

如需详细的基准测试信息并重新运行评估代码,请参考 Fastchat MT - bench 方法。我们已将每个模型的答案、提示和评估结果包含在 HERE 以供复现。生成的结果也可以在 HERE 进行人工评估。

Open LLM Leaderboard 评估结果

详细结果可以在 这里 找到。

| 指标 | 值 |

|---|---|

| 平均 | 47.87 |

| AI2 推理挑战(25 次少样本学习) | 51.71 |

| HellaSwag(10 次少样本学习) | 73.82 |

| MMLU(5 次少样本学习) | 45.34 |

| TruthfulQA(0 次少样本学习) | 44.89 |

| Winogrande(5 次少样本学习) | 70.09 |

| GSM8k(5 次少样本学习) | 1.36 |

🔧 技术细节

ToRoLaMa 的预训练模型基于 Vietnamese - LLaMA2,这是 bkai - foundation - labs 提供的 LLaMA 2 模型的微调版本,并使用大量越南语数据集进行了增强。然后,该模型使用 430K 高质量、多轮问答进行训练。训练数据来源包括 UIT - ViQUAD、[Bactrian - X](https://huggingface.co/datasets/MBZUAI/Bactrian - X)、[Grade - school - math](https://github.com/openai/grade - school - math) 等,以及我们内部包含多个主题对话的数据。

📄 许可证

ToRoLaMa 遵循 ToRoLaMa 社区许可证 协议,同时也遵循 LLaMA 2 Community License,版权所有 © Meta Platforms, Inc. 保留所有权利。

免责声明

本模型源自 Meta 的 LLaMA - 2 模型,因此严格遵守 LLaMA 2 社区许可协议。我们明确声明,对于模型输出的准确性、可靠性、可用性或完整性,以及其中呈现的数据,不提供任何保证、担保或承诺。对于因使用我们的模型而产生的任何直接或间接损失、损害或不利后果,我们不承担任何责任。请注意,模型生成的内容可能包含不准确信息、亵渎性语言、仇恨言论、歧视性言论和/或误导性叙述。将此模型或其衍生产品用于商业目的时,必须完全遵守所有适用的当地法律法规,确保模型生成内容的合法性。对于使用 ToRoLaMa 及其相关文件开发的任何产品或服务,我们不承担任何责任。

致谢

本工作使用了 [bkai - foundation - labs](https://huggingface.co/bkai - foundation - models/vietnamese - LLaMA2 - 7b - 40GB) 和 [fastchat](https://github.com/lm - sys/FastChat/tree/main) 及其参考文献。

如果您使用 ToRoLaMa,请在您的出版物中引用我们的工作:

@misc{allbyai2023ToRoLaMa,

title={ToRoLaMa: The Vietnamese Instruction - Following and Chat Model},

author={Duy Quang Do, Hoang Le and Duc Thang Nguyen},

year={2023},

note={https://github.com/allbyai/ToRoLaMa}

howpublished={Software}

}

Transformers

Transformers Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语