🚀 QwQ-32B-Snowdrop-v0

QwQ-32B-Snowdrop-v0 是一款具有出色性能的模型,它融合了多个优质基础模型的特点。在角色扮演、推理等场景中表现良好,能够生成多样化且结构合理的回复,具有很大的应用潜力。

QwQwQwQwQwQ 和 Marigold 在一场派对上相遇并一见如故...

Has 的评价:这模型真的相当不错!

Severian 的评价:在家进行角色扮演时使用 R1,实际上这个模型能很好地处理包含特殊技巧和微妙策略的内容。搭配合理的推理起始提示,每次重新生成回复时,都能得到结构一致且具有一定多样性的回复。尽管我更注重写作风格,但角色和场景的刻画依然出色,有时还能正确引用相关设定。开启思考模式时,混乱表述的问题并不严重。很少观察到用户模仿的情况。如果你利用好它的特点(专注于写作风格),其生成的散文会让人耳目一新。我原本说 Marigold 会是我的日常首选,但现在这个模型取而代之了,它太棒了。

🚀 快速开始

✨ 推荐设置

- 上下文/指令模板:ChatML。

绝对没有使用 ChatML 指令和 Mistral v7 模板进行测试哦,没有啦。

- 采样器设置:温度设为 0.9,最小概率(min_p)设为 0.05,顶部概率(top_a)设为 0.3,尾部自由采样(TFS)设为 0.75,重复惩罚(repetition_penalty)设为 1.03,如果可以使用动态重复惩罚(DRY)也可开启。

在我们的测试中,基于 virt - io 的衍生提示效果最佳,但你也可以根据喜好选择。

ST 的主导入链接:https://files.catbox.moe/b6nwbc.json

🔍 推理建议

你可以自由测试你最熟悉的推理设置,以下是我的推荐。我的提示中有这样一行:

风格偏好:鼓励使用日本轻小说的写作风格。

基于此,我的推理起始提示是:

<think>好的,在这个场景中,回复之前我需要考虑提示中提到的写作风格,即

至少在测试过程中,这样的设置为推理提供了一个可遵循的结构,每次重新生成回复时都会关注提示的这部分内容。

不过,回复仍然具有多样性,因为后续段落会深入到角色细节等方面。你可以尝试创建自己的思考/推理起始提示,专注于你期望从回复中获得的内容,以达到最佳效果。

— Severian

📚 详细文档

🌟 感谢语

非常感谢 trashpanda - org discord 群里的朋友们进行测试并分享日志!

👍 评价

优点:

- 在 10 次测试中,只有两次出现代表 {{用户}} 发言的小问题。(不过,通过良好的提示可能可以解决这个问题。)

- 创造力:10 次测试中有 8 次,回复的 90% 内容都是独特的,几乎没有陈词滥调。

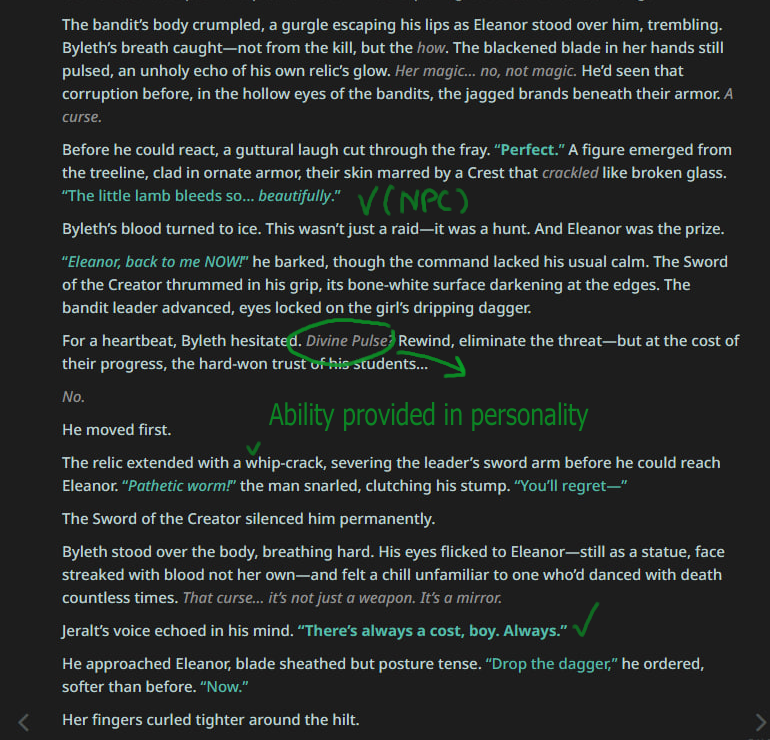

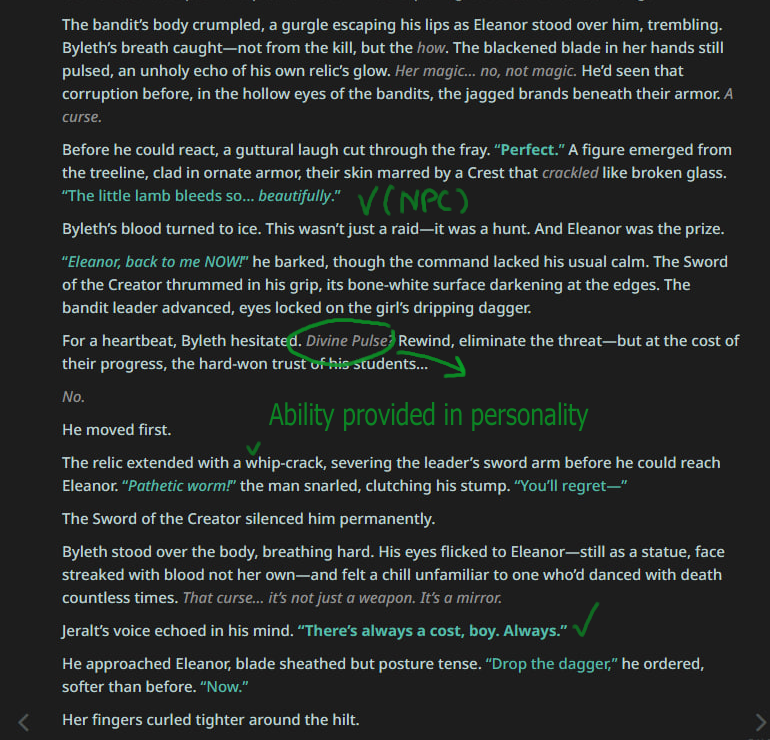

- 角色刻画:能考虑角色的个性并很好地保持一致。即使没有设定集支持,也能记住特定的设定术语并正确理解其含义。

- NPC 表现:10 次测试中有 6 次,NPC 角色也参与到行动中,遵循开场信息中提供的关于他们的信息。有些 NPC 甚至有独特的说话方式。(如果有合适的设定集,效果会更好。)

- 战斗场景描述:对战斗场景的描述毫不保留,魔法攻击、物理攻击等都能详细呈现。

缺点:

- 有些回复有点不符合角色设定。有些回复比较平淡,对角色扮演的上下文提供的信息很少或没有分量。

在我最近尝试的所有模型中,这个模型绝对最有潜力。通过合适的提示,我认为这个模型在独特场景中会成为最好的模型之一。

— Sellvene

这可能是目前最好的小型思考模型之一,甚至可能是最好的。它对角色的把握非常好,混乱表述几乎不存在,当然还是有一点点。它能很好地推进故事并遵循提示。我喜欢 R1,但现在我更喜欢 Snowdrop,因为它的回复感觉更真实,相比 R1 不那么激进。

— Carmenta

它的写作能力比 GPT 4.5 还好。总体来说,我认为审查机制影响了一些更自由奔放的模型,这个模型对我来说太温和了。我还注意到,它过于追求与角色设定一致,不敢偏离设定。

— Myscell

我太惊讶了,它在思考过程中的角色分析和 R1 很相似。角色处理看起来很棒。如果融合能达到这么好的效果,我很期待 QwQ 的微调版本。

— Sam

混乱表述几乎可以忽略不计,而且没有正向偏差,这很好。到目前为止,我很喜欢这个模型,在家用它就像用 R1 一样顺手。

— Raihanbook

总体来说,我认为这是一个非常可靠的模型。上下文处理能力很棒,能很好地遵循我的提示。说实话,在推理方面它是第一名。它对角色和个性细节的刻画?完美。叙述也很完美。我对这个模型几乎没有什么抱怨,你们做得太棒了。

— Moothdragon

在我这里,没有正向偏差🤔 角色和场景的刻画很好。生成的散文我也很喜欢。在这个模型和 Marigold 之间,我现在更倾向于 Snowdrop。不过目前,还是 Marigold 用得更多一些。

— Azula

说实话,我印象深刻,很喜欢这个模型。

— OMGWTFBBQ

这模型相当不错,我觉得比 Mullein 好。

— br

到目前为止,它表现非常出色。我还没发现它有视角混乱的问题。

— Overloke

😜 轻松时刻

📋 日志

(在以 Gemini 开始的一轮测试后)

(在以 Gemini 开始的一轮测试后)

🔧 合并详情

合并方法

此模型使用 TIES 合并方法,以 Qwen/Qwen2.5-32B 为基础模型进行合并。

合并的模型

以下模型参与了合并:

配置

以下 YAML 配置用于生成此模型:

models:

- model: trashpanda-org/Qwen2.5-32B-Marigold-v0-exp

parameters:

weight: 1

density: 1

- model: trashpanda-org/Qwen2.5-32B-Marigold-v0

parameters:

weight: 1

density: 1

- model: Qwen/QwQ-32B

parameters:

weight: 0.9

density: 0.9

merge_method: ties

base_model: Qwen/Qwen2.5-32B

parameters:

weight: 0.9

density: 0.9

normalize: true

int8_mask: true

tokenizer_source: Qwen/Qwen2.5-32B-Instruct

dtype: bfloat16

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语

(在以 Gemini 开始的一轮测试后)

(在以 Gemini 开始的一轮测试后)