🚀 波斯语米斯特拉尔7B模型

波斯语米斯特拉尔7B模型是专门为波斯语问答和自然语言处理任务设计的微调版本模型,能有效提升波斯语相关任务的处理能力。

模型描述 |

输出示例 |

基准测试结果 |

使用方法 |

训练与微调

🚀 快速开始

以下是使用该模型的简单步骤,你可以按照下面的代码示例进行操作。

✨ 主要特性

- 基于米斯特拉尔7B模型进行微调,专为波斯语问答和自然语言处理任务设计。

- 通过在多个波斯语数据集上训练,提升了对波斯语的理解和处理能力。

📦 安装指南

使用该模型需要安装transformers库,你可以使用以下命令进行安装:

pip install transformers

💻 使用示例

基础用法

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("aidal/Persian-Mistral-7B")

model = AutoModelForCausalLM.from_pretrained("aidal/Persian-Mistral-7B")

input_text = "پایتخت ایران کجاست؟"

input_ids = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**input_ids)

print(tokenizer.decode(outputs[0]))

📚 详细文档

模型描述

波斯语米斯特拉尔是米斯特拉尔7B的微调版本,专为波斯语问答和自然语言处理任务而设计。

输出示例

示例1:

- 输入:"درمان اصلی برای افراد مبتلا او آر اس، جایگزینی مایعات و الکترولیت ها در بدن"

- 训练后输出:"درمان اصلی برای افراد مبتلا او آر اس، جایگزینی مایعات و الکترولیت ها در بدن است. که به طور معمول از طریق تزریق وریدی استفاده می شود."

- 训练前输出:" درمان اصلی برای افراد مبتلا او آر اس، جایگزینی مایعات و الکترولیتها.The most important treatment for people with diarrhea is oral rehydration solution."

示例2:

- 输入:"سال ۱۹۴۴ متفقین به فرانسه اشغال شده توسط آلمان، در عملیاتی در نرماندی حمله کرده و"

- 训练后输出:"سال ۱۹۴۴ متفقین به فرانسه اشغال شده توسط آلمان، در عملیاتی در نرماندی حمله کرده و 150,000 نفر از آنها را کشتند."

- 训练前输出:"سال ۱۹۴۴ متفقین به فرانسه اشغال شده توسط آلمان، در عملیاتی در نرماندی حمله کرده و خرج گرفت.The United States and France have condemned the killing of a French aid worker in Afghanistan by Tal"

基准测试结果

| 模型 |

数据集 |

得分 |

| base-model-7b |

ARC-easy |

41.92% |

| base-model-7b |

ARC-easy |

39.12% |

| fa-model-7b |

ARC-easy |

37.89% |

| base-model-7b |

ARC-challenge |

37.12% |

| fa-model-7b |

ARC-challenge |

39.29% |

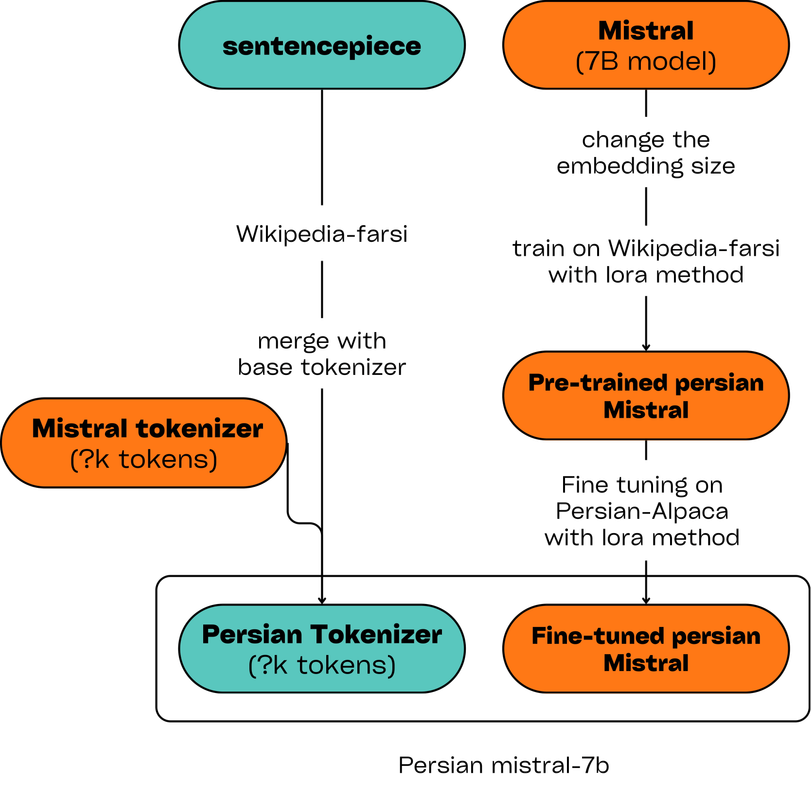

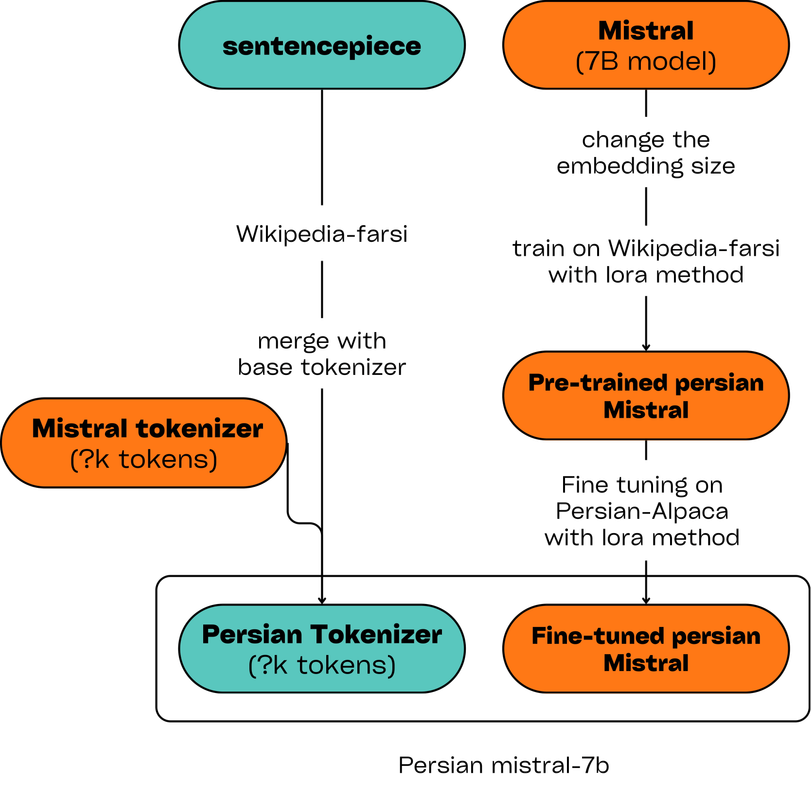

训练与微调

- 扩展分词器:基础的米斯特拉尔分词器不支持波斯语。作为初始步骤,我们在波斯语维基百科语料库上训练了一个SentencePiece分词器,随后将其与米斯特拉尔分词器集成。

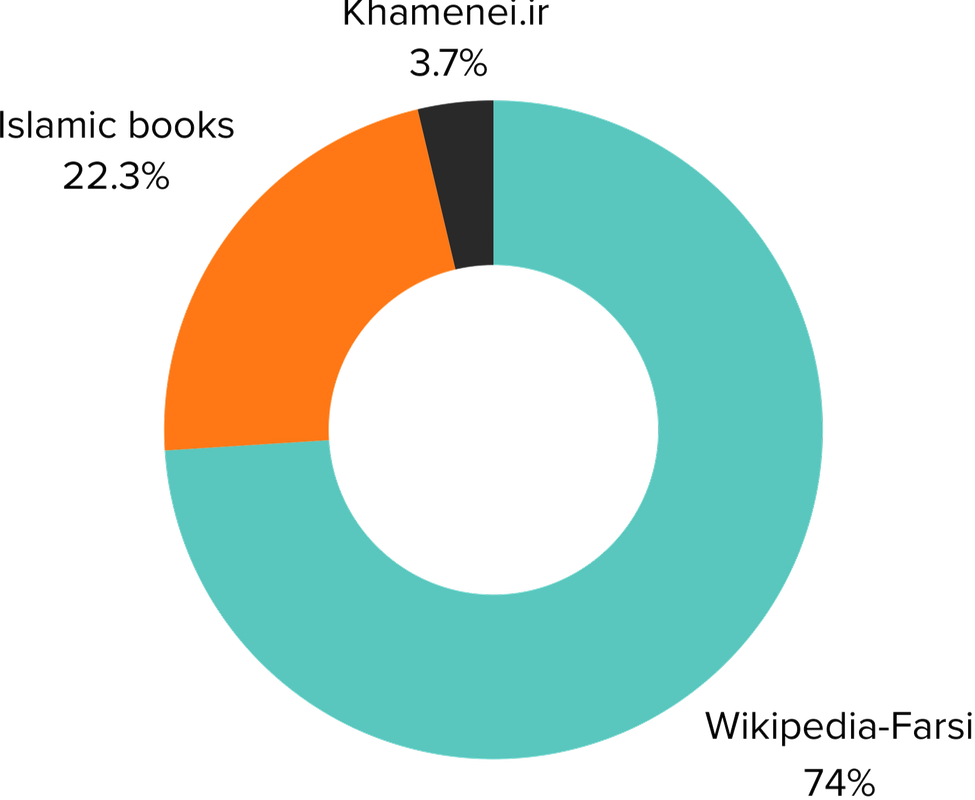

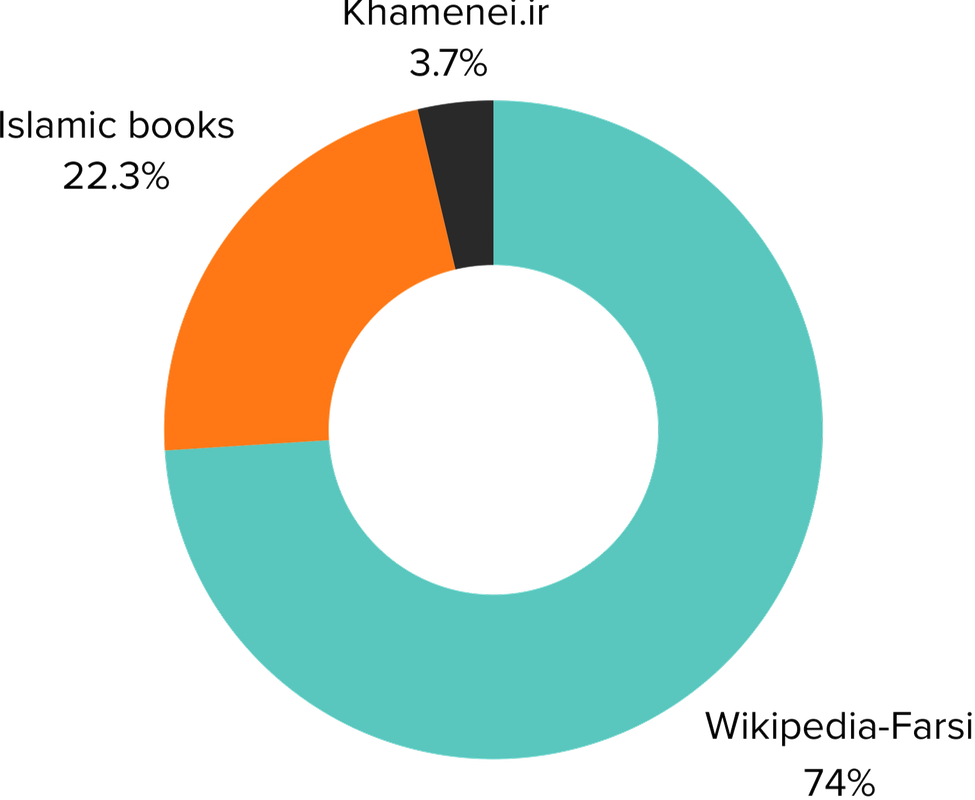

- 预训练:在接下来的步骤中,我们扩展了基础模型的嵌入层,使其与波斯语分词器的大小相匹配。然后,我们使用LoRA方法在三个不同的数据集上训练模型:波斯语维基百科、伊斯兰书籍集合和Khamenei.ir的内容。

波斯语维基百科:1.83亿个词元,伊斯兰书籍:5500万个词元,Khamenei.ir:900万个词元

- 指令微调:在最后一步,我们使用LoRA方法在斯坦福阿尔帕卡的翻译版本上对模型进行微调,以增强模型的问答能力。

以下图表展示了上述步骤:

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语